Classement

Contenu populaire

Affichage du contenu avec la meilleure réputation le 11/09/2022 dans toutes les zones

-

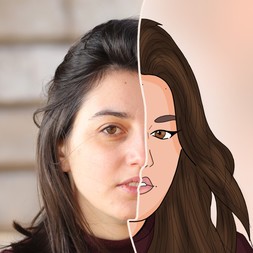

Hello ! Premier challenge pour moi ! L'univers et la façon dont il est amené m'inspire vachement, j'ai décidé de franchir le pas et de me lancer 😄 Je commence avec le personnage de Lirana. En faisant des recherches pour m'inspirer, je suis tombé sur une illustration sur Pinterest (ci dessous) qui m'a bien plu : Une sorcière avec un PC portable. Je trouve le concept d'une étudiante d'aujourd'hui dans une université de magie très sympa. Et j'ai bien relu le descriptif, je ne pense pas être hors sujet. Voilà mes premiers coups de crayons ou j'essaye de chercher un peu la base de mon painting : Pour les éléments du monde moderne j'ai mis : un burger et un sac de pharmacie (médocs contre les crises magique), un casque audio et un gobelet de café. A des moments je me dis que ce n'est pas assez pour qu'on comprenne le concept, à d'autres je me dis que le burger est de trop 😅 N'hésitez pas à me faire part de vos remarques 😁5 points

-

5 points

-

Bonjour à tous, j'ouvre un WIP pour le Challenge 15. Kranos: Je commence le concept de Kranos. Ce n'est pas super propre, mais là, j'essaye de faire le maximum d'itérations le plus rapidement possible. Ensuite, je vais garder les meilleures idées. Voilà le design final : Maintenant, on attaque la composition, je suis parti sur l'idée que mon perso travail sur le confectionnement de sa magie de sa chambre d'étudiant. On teste un workflow 3D : D'habitude en ce qui concerne la 3D, je me contente de faire une pose avec Clip studio paint ou d'ajouter quelque volume 3D basique. Mais en parcourant les Wip du Forum, ça m'a donné envie d'essayer d'aller plus loin. Donc j'ai testé Blender. C'est très fun mais j'ai bien galéré, surtout pour les habits, d'ailleurs on voit que ce n'est pas très propre. Mais ce n'est pas bien grave parce que je vais peindre au dessus. Au final je pense que la 3D va représenter 60 à 70 % du travail. Donc pour l'instant ça donne ça : Une petite création d'alphabet magique pour les sorts avec caligraphr : Ensuite j'ai utilisé ses runes pour designer les cercles magiques : Ceux de Leonardia sont plus classiques, ils ressemblent plus à des cercles d’alchimie. Ceux de Grondark, sont plus modernes puisque l'école fut fondée plus tard aussi ils sont plus géométriques pour donner un aspect plus scientifique: Kranos doit mixer les deux formes de magie : Mise à jour de mon illustration : On passe au rendering !4 points

-

4 points

-

4 points

-

4 points

-

3 points

-

@stefou Merci, en vrai je préfère la préprod/les aspects techniques (orthos, callouts, designs de bâtiments) et je déteste finir des trucs type illustration, la peinture ce sera pour après une fois la tablette changée😛 Là je vais pousser la 3D une fois que j'aurais suffisamment de recul dessus @j-lejeune Merci, j'essaie de pousser les concepts comme je peux, j'ai vraiment peur d'avoir des designs trop génériques @archanges Merci, voilà la suite mais pour d'autres explorations faudra attendre ma nouvelle tablette :v Je vais ptêtre réutiliser un voile sur l'arrière de la statue, on va voir ~ La statue de Tchawampa s'est mangé une tique (je pense partir sur un mix entre O, N, P parce que ça donne un petit côté FS et que concepts sinistres >>>>> concepts pas sinistres). Après je peux peut-être lui ajouter un lien avec le fond sous forme de cape ? A voir ? Recherches piliers 3D coat Après celle-ci elle est bien aussi : Compos crades. Pas sûre de l'angle de vue, ni de si le bâtiment doit être ouvert ou pas, mais en soit cette vue me paraît ok pour montrer les objets principaux et les kikiwams, une vue de haut ce serait délicat et mauvais pour la vue de la statue (sauf avec un perso entouré des kikiwams peut-être). Des retouches rapides sur le pandérin, vous pouvez voir où mon stylet a bugué c'est insupportable EDIT : Au final ce serait bel et bien un cadrage proche des marches ainsi, avec du côté ouvert pour montrer une autre dimension ?3 points

-

3 points

-

Bonjour tout le monde ! Puisque je ne l'ai pas fait hier, je vous poste ici mon croquis fait hier avec le petit lapin ! Je pense faire encore deux photos proposées par Spartan, puis je partirai peut-être sur autre chose, à voir ! En tout cas, je m'amuse énormément sur ce chapitre et je me sens plutôt à l'aise avec le thème. Je prends bien sûr tous les commentaires 😉 !3 points

-

J'ai enfin mis ma base! ouffff lol. à Assez satisfait jusqu'à présent et avec les couleurs de placées en mode incrustation par dessus les valeurs de gris, je me rend compte que j,adore cette technique et pense bien avoir trouvé mon style et ça c'est cool. 🙂 j'attaque le décor et je viendrais corriger les petits détails vers la fin.3 points

-

2 points

-

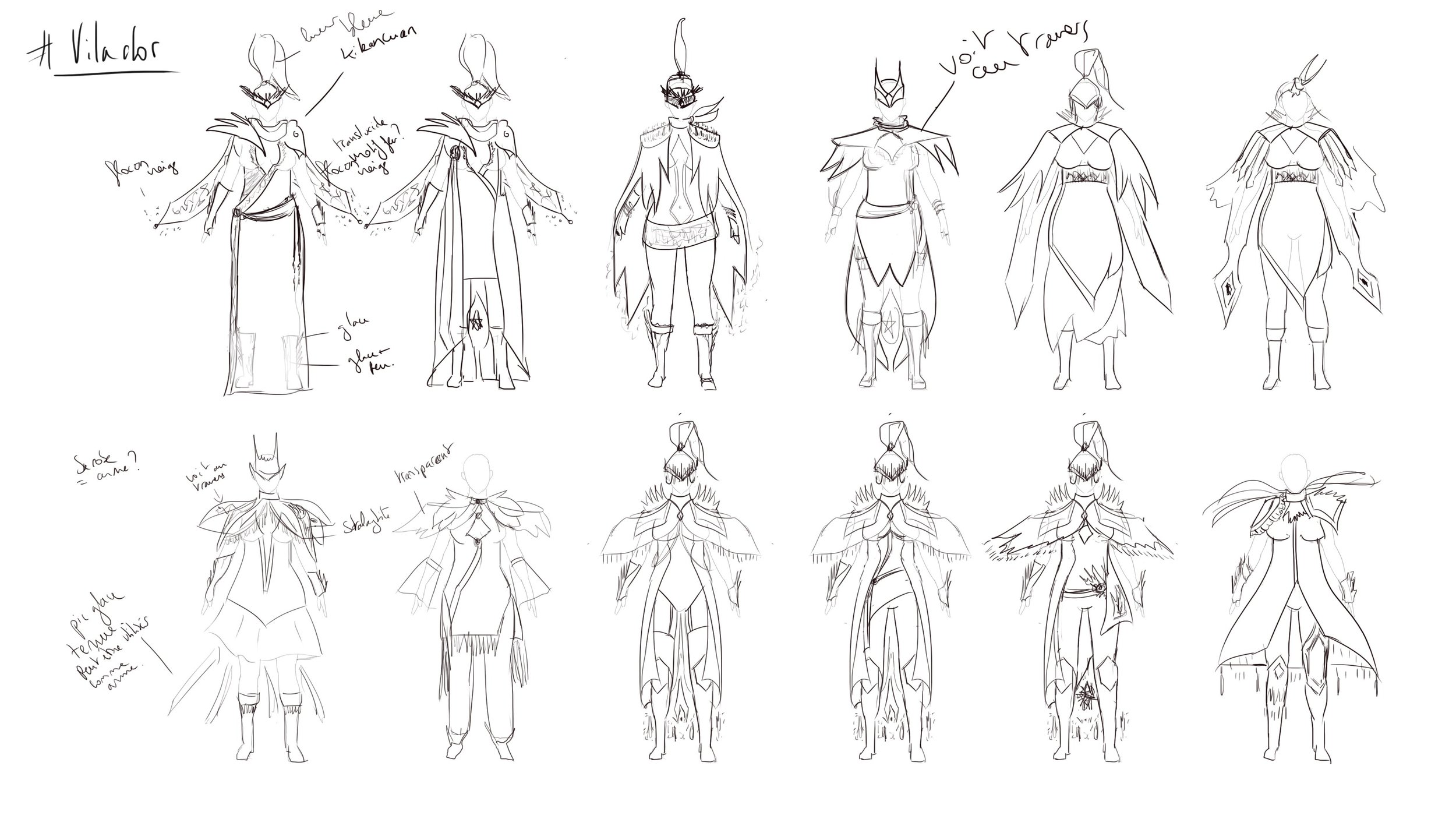

Je ne sais pas si j'aurais le temps d'aller jusqu'au bout, vu que je ne suis pas là en décembre. J'ai pris comme sujet Vilador. Rappel : Université : Chaudvent Vilador est une des professeurs de Chaudvent. Elle y enseigne les magies de l’air et du feu bien qu’elle maîtrise également la magie de glace. Elle est souvent décrite d’une grande beauté et aux formes généreuses. Cela dit, sa grâce ne fait que masquer une magicienne au talent redoutable et à l’esprit toujours vif qui analyse tout. Elle porte de grandes épaulières et ses étoles flottent constamment au-dessus et autour de ses épaules. Sa tenue faite partiellement de glace la met encore plus en valeur. Autant dire qu’elle ne manque pas de charisme autant que d’intellect. Comme pour tous les hauts membres de Chaudvent, personne ne sait quels sont ses objectifs, si ce n’est la quête du savoir, d’une manière ou d’une autre. Voici ma première planche de recherche. Pas trop satisfaite pour l'instant.2 points

-

Yo ! je poste ici mes différents travaux pour le challenge, je compte faire beaucoup de sujets pour ne choisir que mes 3 meilleurs illus à poster à la fin du challenge ! 🙂 Je démarre avec Bayne, j'ai fait 2 planches de concepts pour lui, je vais passer à l'illustration finale demain : Ces concepts ne sont pas définitifs, je changerais peut être 2-3 choses sur l'illustration finale 🙂2 points

-

2 points

-

J'ai commencé quelques croquis pour le character design de Sviktan (enseignante de l’université de Ruysdran). Malgré le fait qu'elle a l'air dure, dangereuse, je l'imagine avoir eu un passé très difficile avant d'être ce qu'elle est devenu. Je posterai ici toutes mes avancées pour mes participations.2 points

-

2 points

-

Coucou à tous, bon, avec l’encouragement sur YouTube de @Spartan de DPSchool, j’ose même me lancer … enfin… j’espère ne pas trop être déçu par le jury …. non, je voulais dire par moi même 😝 je vais faire deux ou trois personnages de l’académie leonardia. Pour moi, si c‘est le lieu de l’apprentissage de la transformation de la matière ou des corps, les costumes doivent être légers pour qu’on puisse les transformer et/ou voir les corps se transformer donc je vais vers des costumes plus sexy et j’espère un peu différent de l’image que l’on a des mages comme Harry potter influences inconscientes : final fantasy 10, Harry poter et piraterie2 points

-

Bonjour à tous, Voilà pour ma modeste participation. J'ai utilisé en majorité une brush mélangeur, mais trop humide je pense et pas assez espacé. ~1h @peyrine c'est plutôt bien parti. Il faudrait ajuster les valeurs pour coller à l'originale et reprendre quelques lignes de perspectives, notamment celles du pont et les toits à cette même hauteur. Le traitement est chouette et assez fidèle dans l'ensemble.2 points

-

2 points

-

2 points

-

2 points

-

hélas je ne suis plus sur Adobe 😃 mais sur Affinity maintenant.. Je vais regarder si c'est compatible ^^ En attendant, voici ma participation (j'ose 😌). Merci pour l'exercice, super intéressant de s'entrainer sur les valeurs, même si le rendu n'est pas une copie conforme (je l'ai plutôt traité en mode sketch) je suis plutôt contente du rendu 🙂 il me manquerait du temps pour compléter et aller plus loin2 points

-

Je partage également des petits croquis que je réalise au crayon parce que je suis plus à l'aise qu'avec la tablette. J'essaye de varier les techniques d'idéation pour voir ce qui me correspond le mieux, après tout le challenge est un peu une extension des cours ! Je partage une vidéo que j'ai trouvé très intéressante pour développer des idées, peut être que ça pourra vous aider aussi (c'est en anglais) ! J'essaye de m'en inspirer ici. J'essaye de bien respecter le brief en m'inspirant de divers animaux : cerf / lion / lynx (et renard et ours qui sont dans le brief bien sûr) . Pour l'instant j'ai du mal à garder l'esprit "ours" sans faire un animal mastoc ! J'aime bien la silhouette que j'avais obtenu avec les silhouettes. Je vais continuer à explorer2 points

-

Hello ! C'est vraiment un très bon concept que tu nous prépares là ! 🙂 Juste pour chipoter un peu. Certains éléments de son anatomie me gêne un peu, notamment ses jambes que je trouve trop longues par rapport au haut du corps. Dans l'idée, la hauteur du haut de la tête au pubis doit être à peu près la même que la hauteur du pubis jusqu'aux pieds 🙂 Après rien ne t'empêche de casser cette base, à ton bon vouloir ! je suis aussi dérangé quand je regarde sa tête, j'ai l'impression qu'elle est un peu petite par rapport au reste du corps, enfaite je sais pas si c'est la tête ou le cou qui est trop petit. En tout cas c'est déjà super bien, hâte de voir le décors ! PS : Je suis très content pour toi que tu ai trouvé une méthodologie et un style qui te convienne, n'hésite pas à en abuser dans ce cas 😄2 points

-

J'ai eu un petite idée qui à germé tout à l'heure, on peux faire 3 illu pour le challenge, donc mon idée c'est de faire une suite de keyframes pour le ballon prisonnier. Ca fera une suite d'illus qui racontera le debut, le milieu et la fin du match! Je fais une petite pause donc sur l'illu en cours et j'ai fais un ptit concept pour l'arriver des joueurs, qu'en dites vous ? (je pense que je ne vais pas dormir les deux prochains mois, mais ca vaut le coup, en tout cas je suis très hyper !! ) La bonne nuit ! 🙂2 points

-

Initialement j'ai posté ce sujet dans les WIP parce qu'après tout, mon projet est bien à l'état de WIP, mais si ça peut permettre d'informer les gens et d'apaiser leur anxiété, je ne vois aucun problème à ce que le sujet soit déplacé dans une section plus pertinente. 😄 Le sujet mérite effectivement discussion. Je pense m'attarder sur la question en prenant en compte l'aspect technique. Je ne peux pas le faire de suite parce qu'il faut que je sorte, mais d'ici la fin de la semaine, c'est possible. De mon point de vue, le vrai noeud du problème tient dans la constitution d'une base de données d'entraînement avec des contenus extraits à l'insu de leurs auteurs. Dans le cas d'une base de données d'entraînement construite en toute légalité et toute transparence par des auteurs recrutés à cet effet ou avec des données qui appartiennent à l'organisme qui développe l'IA, j'estime que le statut d'une oeuvre créée à l'aide d'une IA ne devrait pas être différent de celui d'une oeuvre créée avec Photoshop, CSP, Procreate, Blender... Je détaillerai mon point de vue. En vérité j'ai vraiment un problème avec le terme "IA" pour les algorithmes de machine learning. x) En tout cas, si ce contenu vous a plu et paru utile, j'en suis heureuse. Merci à vous d'avoir eu la patience de lire. 😄2 points

-

2 points

-

2 points

-

Petit récapitulatif avant de commencer des compo, et en bonus, un peu de storytelling ! La naissance de Sviktan Abandonnée à elle-même depuis ses dix ans, après le meurtre de ses parents, riches et redoutés de tous, grâce à leurs pouvoirs et leur emprise sur la société, Sviktan se fît passer pour morte, errant les rues sales d’une grande métropole. Elle réussit, malgré son jeune âge, à se faire respecter. Une aura maléfique émanait de son petit gabarit, car la vengeance et la colère avaient déjà pris le dessus. Sachant que la magie noire permet un pouvoir « dit » beaucoup plus puissant que la magie blanche, elle se dirigea vers celle-ci, influencée par un homme beaucoup plus âgé qu’elle, qui prendra place à ses yeux une image paternelle. Homme qui, était un grand mage de Ruysdran. Elle se fera dévorer par l’obscurité et la folie. Car, derrière son visage glaçant et méprisant, se trouve un être perdu dans le chaos.2 points

-

Bibliographie OpenClassrooms, Apprenez les bases du langage Python : https://openclassrooms.com/fr/courses/7168871-apprenez-les-bases-du-langage-python Le Python, c’est un langage très populaire de nos jours. Il est présent dans un tas de domaines différents. Il est utilisé pour scripter ou développer des plugins dans la plupart des logiciels de 3D dont Blender. C’est aussi le langage le plus complet pour faire de la data science et du deep learning. Machine Learnia : https://www.youtube.com/c/MachineLearnia Une chaîne YouTube pédagogique qui propose une initiation au machine learning, au langage Python dans le cadre du machine learning et une troisième sur le deep learning. Je vous recommande d’ailleurs la première vidéo de la formation de deep learning. Elle retrace l’histoire des réseaux de neurones artificiels tout en expliquant les bases de leur fonctionnement. OpenCV Python Tutorial (en English) : https://www.geeksforgeeks.org/opencv-python-tutorial/ OpenCV est une librairie de manipulation d’images. Elle est disponible en Python et dans d’autres langages. Je l’ai utilisée pour mon programme de multiplication des données d’entraînement, entre autres. Réseau de neurones avec Tensorflow : https://khayyam.developpez.com/articles/intelligence-artificielle/tensorflow/ Tensorflow est une des bibliothèques qui permet de monter un réseau de neurones comme un jeu de Lego, de l'entraîner, puis de l’exécuter. Dans ce tuto, on apprend à développer un réseau de neurones capables de classifier des chiffres écrits à la main. Tensorflow et les réseaux antagonistes génératifs : https://khayyam.developpez.com/articles/intelligence-artificielle/tensorflow-gan/ Les réseaux antagonistes génératifs sont les modèles utilisés pour la création d’images. Ils se composent de 2 réseaux de neurones. L’un génère des images, l’autre identifie si une image est réelle ou si c’est un fake généré artificiellement. Les 2 réseaux s’entraînent en tandem : pendant que le discriminateur s’entraîne à distinguer les images réelles des images artificielles avec plus de précision, le générateur s’entraîne à créer des images qui vont tromper le discriminateur. Dans ce tuto, on apprend à créer un réseau capable de générer un chiffre écrit à la main. How to Develop a Conditional GAN (cGAN) From Scratch (en English) : https://machinelearningmastery.com/how-to-develop-a-conditional-generative-adversarial-network-from-scratch/ Dans ce tuto, on apprend à développer un GAN conditionnel. C’est comme le précédent, sauf qu’on précise en entrée quel type d’objet on veut générer dans notre image. How to Develop a Pix2Pix GAN for Image-to-Image translation (en English) : https://machinelearningmastery.com/how-to-develop-a-pix2pix-gan-for-image-to-image-translation/ Il s’agit de l’algorithme que j’ai utilisé ! Il permet de transformer une image en une autre. Il est entraîné sur la base de couples d’images sources et cibles. Et pour finir, les bouquins que je potasse en ce moment. Je les ai achetés à la librairie Eyrolles à Paris. Ils se commandent aisément sur Internet. Voilà, voilà ! Merci de m’avoir lu jusqu’au bout. Je compte sur vous pour envoyer des illustrations hors d’atteinte des IA pour le challenge ! 😄 Bonne nuit ! 😴2 points

-

Comment ça marche ? Pour commencer, faisons une petite précision sur le type d’IA qui fait beaucoup parler de lui de nos jours, il s’agit du deep learning. L’intelligence artificielle est en réalité un champ d’étude très vaste regroupant des sous domaines qui ont eux-même des sous domaines. Le machine learning est un sous domaine de l’intelligence artificielle et le deep learning est lui-même un sous domaine du machine learning. Je vous explique le principe de fonctionnement sans vous assommer avec les détails techniques. Vous verrez que finalement, qualifier ces algorithmes d’”intelligence” artificielle est un putain d’abus de langage. Le principe de base du machine learning Bon, vous allez être un peu surpris mais… Le machine learning, vous en avez tous fait à l’école sur papier. Si si ! Je vais vous montrer. Vous avez sûrement déjà vu ce genre de graphique et on vous sûrement déjà demandé de tracer à la règle une droite qui passe le plus près possible de tout ces points. Pour l’anecdote je me souviens l’avoir fait en cours de physique au collège. La prof nous avait donné un graphique avec des mesures de la température d’ébullition de l’eau en fonction de l’altitude. Elle nous a demandé de tracer la droite la plus proche possible de tous les points, comme ceci : C’est une fonction affine de type y = ax + b. Ensuite, elle nous a demandé de placer 2 points dessus et de mesurer leur position pour calculer les paramètres a et b de la fonction affine et pour finir, à l’aide de ces paramètres calculés, elle nous a demandé de prédire la température d’ébullition de l’eau pour une altitude donnée. Et bien voilà, le machine learning, ce n’est rien d’autre que ça : utiliser les données récoltées pour calculer les paramètres a et b optimaux pour construire un modèle de type y = ax + b qui soit capable de prédire la valeur de y par rapport à une donnée x avec la marge d’erreur la plus petite possible. C’est con, hein ? 😄 Comme vous pouvez le voir, la droite n’est qu’une approximation et il est impossible de la faire passer par tous les points. Tout ce qu’on peut faire c’est essayer d’avoir la marge d’erreur moyenne la plus petite possible, mais elle ne pourra jamais tomber à zéro. Alors on pourrait imaginer un modèle beaucoup plus compliqué capable de passer par absolument tous les points, comme ceci : Modèle de type Mais vous voyez bien que ce modèle est complètement absurde par rapport à la réalité de la physique et que si vous ajoutez une nouvelle mesure dans les données, comme ceci : Et bien la marge d’erreur est même encore plus grande que si vous vous étiez contenté d’une simple droite. C’est le problème de la généralisation du modèle. Un bon modèle doit être capable de minimiser les erreurs sur les données d’entraînement, mais tout en les minimisant sur de nouvelles données aussi. Le travail d’un data scientiste consiste donc à analyser les données et sélectionner un modèle qui propose le meilleur compromis possible entre la précision vis à vis des données d’entraînement et la capacité de généralisation. La perfection est impossible à atteindre parce qu’il y a des fluctuations et du bruit dans les données. La droite est un exemple. Selon la distribution des données on peut avoir besoin d’un modèle différent, comme ici : Ici on a un modèle de type et il faut optimiser les paramètres a, b et c. Voilà pour les bases du machine learning. La particularité du deep learning, c’est qu’on ne va pas ajuster 2 ou 3 paramètres, mais des millions, voire des milliards de paramètres pour traiter des paquets de données en vrac. Mais le principe est identique. Le deep learning Les schémas que je présente dans cette section sont des captures d’une vidéo de la chaîne Machine Learnia sur le thème du Deep Learning sur Youtube. Je vous parlerai de cette chaîne dans la bibliographie. Le premier concept de neurone artificiel a été élaboré par deux mathématiciens, Warren McCulloch et Walter Pitts, en… 1943 ! Je vous avais prévenus que vos parents n’étaient pas encore nés. x) Rappelons le principe de fonctionnement d’un neurone, un vrai. En orange, vous avez les dendrites qui sont connectées aux terminaisons d’autres neurones. Elles sont excitées ou non selon que les neurones qui les précèdent le sont ou non. Si le niveau total d’excitation dépasse un certain seuil, le neurone est à son tour excité et transmet l’information à ses terminaisons (en vert) qui sont elles-mêmes connectées aux dendrites d’autres neurones. Et bien le neurone artificiel s’inspire du même principe : il fait la somme des signaux x qui peuvent être des données d’entrée ou le résultat d’autres neurones artificiels (on appelle cette étape agrégation), il vérifie que cette somme dépasse un certain seuil, ou pas et si c’est le cas, le résultat y vaut 1, sinon il vaut 0 (c’est l’étape d’activation). Notez que lors de l’agrégation, toutes les entrées n'ont pas la même influence. Celle-ci est définie par les paramètres w. On appelle cela les poids et c’est de ces poids que dépend la fonctionnalité du neurone. A l’époque nos 2 mathématiciens suggéraient déjà qu’on pouvait organiser les neurones artificiels en réseau. Mais il y a un hic ! Ils n’ont pas proposé d’algorithme permettant d’ajuster automatiquement les poids w, ô combien importants pour pouvoir définir la fonctionnalité qui ressortira du réseau de neurones, il fallait donc les définir à la mimine ! L'engouement pour l’IA est retombé comme un soufflet. Pfffft ! 💨 Il faut attendre 1957 avant que ne soit proposé le premier algorithme d’apprentissage automatique du neurone artificiel. L’idée est proposée par le psychologue Frank Rosenblatt et s’inspire toujours du principe de fonctionnement des vrais neurones. En gros, quand 2 neurones reliés entre eux sont excités en même temps, la connexion entre eux est renforcée. L’algorithme d’apprentissage s’appuie sur cette idée là. Dans la pratique, avant l’entraînement, on donne une valeur aléatoire à tous les poids w. Ensuite, on fait passer les entrées x dans le réseau de neurones qui calcule un résultat y. On compare ce résultat aux données d’entraînement y réelles. On ajuste les poids w de manière à ce qu’ils donnent un résultat plus proche des données réelles. Puis on recommence : on fait passer les entrées x dans le réseau de neurones qui calcule un résultat y. etc etc… Et ainsi de suite jusqu’à ce que la marge d’erreur ne bouge plus. Mais il y a encore un hic ! L’algorithme d’apprentissage proposé à l’époque ne pouvait fonctionner que sur une seule couche de neurones, et ne pouvait donc résoudre que des problèmes qui pouvaient être représentés par une droite. Alors ici, séparer 2 catégories avec une droite pas de problème. Mais là, par contre, on est comme des cons. Le soufflet retombe à nouveau. Pffft ! 💨 Il faut attendre 1986 pour que soit mis au point un algorithme d’apprentissage automatique multi-couche sur une idée proposée en 1974, la back-propagation. Je ne vais pas vous assommer avec des détails techniques, ce sont des math un peu bourrues. Retenez simplement qu’il s’agit d’un algorithme d’apprentissage qui parcourt le réseau de neurones à l’envers pour pouvoir ajuster les poids (d’où le “back”). Les étapes restent toujours les mêmes : Donner une valeur aléatoire à tous les poids. Faire passer les entrées x dans le réseau de neurones qui calcule un résultat y. Comparer ce résultat aux données d’entraînement y réelles. Ajuster les poids w de manière à ce qu’ils donnent un résultat plus proche des données réelles. Faire passer les entrées x dans le réseau de neurones qui calcule un résultat y. etc etc… Si on prend l’exemple d’un réseau de 3 neurones répartis sur 2 couches, on peut déjà résoudre des problèmes plus complexes. Bon, affichons notre petit réseau de neurones avec les opérations que fait chaque neurone. Le truc qu’il faut noter quand vous utilisez une IA, c’est qu’à ce moment-là, elle a fini son entraînement. Les poids w, ils ne bougent plus. Et donc, qu’est ce qu’il fait, là, le réseau de neurones, quand vous l’exécutez ? Il fait juste une grosse suite de multiplications et d’additions… Et c’est tout ! Vous pouvez voir ça comme un méga filtre Photoshop qui fait une opération différente à chaque pixel. J’ai d’ailleurs testé des IA qui ne faisaient pas mieux que des filtres Photoshop. ¬¬ C’est con, hein ? 😄 C’est fou ce qu’on peut faire avec de simples additions et multiplications. Comme vous pouvez le voir, le neurone artificiel ne fait que s’inspirer du principe de base des neurones de notre cerveau, il ne les simule pas. Pour cela il faudrait aller bien plus loin, simuler les réactions chimiques selon les types de neurotransmetteurs et bien d’autres choses que mes maigres connaissances en neurologie ne sauraient vous lister… Le bout de code du neurone artificiel est beaucoup trop simple pour prétendre simuler tout ça. Un réseau de neurones artificiels n’a donc pas grand chose de commun avec un cerveau bien réel. En fin de compte, dire que ce genre d’algorithme peut développer une conscience c’est un peu comme dire que le blender de votre cuisine peut en développer une aussi. Bon, alors du coup, si cet algo est aussi vieux et simple, pourquoi ce type d’IA n’explose que maintenant ? Et bien l’étonnante simplicité du deep learning est aussi son point faible. Outre le fait qu’elle présente, par principe, une limite à la perfection des résultats qu’elle peut produire, celle-ci ne peut fonctionner qu’avec une très grande quantité de données. Sans données pour l’entraîner, une IA créative ne peut générer qu’un bruit aléatoire. Pour pouvoir entraîner des IA de génération d’images, il a donc fallu attendre l’explosion des réseaux sociaux et des smartphones. Les données, on en avait pas assez avant. Second problème, plus un projet d’IA de ce type est ambitieux, plus il faut de neurones et de couches de neurones et plus il faut de données, et plus vous avez de neurones à entraîner et de données, plus l’entraînement est long, et donc, pour économiser du temps, il faut plus de puissance de calcul. La puissance de calcul, on en avait pas non plus assez avant pour avoir des temps d’entraînement raisonnables. Non, le deep learning, ce n’est pas du tout un algorithme éco responsable. x) Pour parler plus grassement, en fin de compte, un projet de Deep Learning, c’est un concours de bites : plus on veut faire un projet ambitieux, plus il faut de moyens (recruter des data scientistes pour récolter et traiter les données, louer des cartes graphiques sur le cloud ou disposer de son propre centre de calcul). Les limites de Midjourney, Dall-E & co Pour en terminer avec le fonctionnement des IA, voici une petite analyse plus poussée des limites des IA génératives actuelles. Pour commencer, voici des captures des galeries de Stable Diffusion et de Midjourney. J’ai aussi refait la même recherche que Spartan sur les démons pour Stable Diffusion. Y’a pas un truc qui vous fait tiquer tout de même ? Une IA c’est très fort pour recracher des choses qui ressemblent aux données d’entraînements, mais c’est beaucoup plus à la peine pour faire quelque chose de nouveau et dans ces galeries on ne vous affiche que les résultats les plus réussis, et dans les résultats les plus réussis, qu’est-ce qu’on trouve majoritairement ? Des portraits, des légions de portraits ! Les concepts de personnages ont tous à peu près le même posing et si on inclut les quelques décors on constate que tout est vu à hauteur d’yeux. Par contre, pour les keyframes du genre un personnage accroupi qui observe une fleur vu en plongée, un bonhomme qui surfe sur un skate volant vu en contre plongée ou 2 personnages qui font un câlin, on repassera. C’est pour ça que la tentative de dragon cyberpunk de Spartan s’est soldée par un bel échec critique : des images de dragons, on en trouve à la pelle, des images de dragons cyberpunk, vachement moins ! Alors, pourquoi cette limitation ? C’est simple, la nourriture des IA, les données, est aussi leur plus grand point faible. Le fait est que sur Internet vous trouverez plus de portraits vus à hauteur d’yeux que de keyframes de malades avec des cadrages improbables, et les personnages qui se tiennent debout dans des poses peu originales, c’est quand même plus facile à dessiner, donc il y en a aussi plus de que des poses complexes. Fatalement, les IA sont plus douées pour recracher ce type de contenu. C’est pas une surprise. Cependant, des photos et des dessins avec des personnages dans des positions variées, il y en a aussi sur Internet, alors pourquoi ces IA sont-elles paumées avec des demandes anatomiquement plus complexes ? C’est simple, elles s’entraînent sur la base de couples image/description et les descriptions des images ne sont absolument pas écrites par les data scientistes de l’équipe de développement, ils ne sont pas assez nombreux. Non, ils utilisent tout simplement des bots qui vont lire la description que l’auteur de chaque image a rédigé et les mots clé qui vont avec. Mettons, vous faites un beau keyframe avec une scène d’action ou une étude de modèle vivant. Lorsque vous publiez votre image sur le net, est-ce que vous vous amusez à rédiger une description complète du posing et du cadrage comme si vous vouliez qu’un aveugle puisse “visualiser” avec précision le contenu de votre image ? Non. Par conséquent, il y a un trou dans les données et l’IA se retrouve avec des images dont elle ne sait pas trop quoi faire et des possibilités qui ne lui sont pas accessibles. Ceci pose d’ailleurs un problème plus grave : les biais culturels et les stéréotypes. Sans traitement manuel, ce que les IA recrachent est à l’image du contenu qu’elles trouvent sur Internet. C’est d’ailleurs comme ça que les tentatives d’IA de conversation ont fini par tenir des propos racistes et que le portail francophone de Google a un jour affiché l’affiche du film Black Panther associée au titre La Planète des Singes en faisant passer ça pour une fiche d’Allo Ciné. Les activistes d’extrême droite savent très bien comment fonctionne le deep learning et comment entuber une IA de ce genre. C’est simple : il suffit de publier une association entre une image et un texte de façon à ce qu’elle devienne plus fréquente que l’association affiche/titre originale. Les développeurs de Craiyon font d’ailleurs une mise en garde à ce sujet dans leur FAQ. https://www.craiyon.com C’est écrit aussi sur le site de Stable Diffusion : https://stability.ai/blog/stable-diffusion-public-release En parlant de câlins, voici un test que j’ai fait avec Midjourney. Décryptage d’un petit exemple. Je lui ai demandé de me “dessiner” les pilotes de Formule 1 Max Verstappen et Lewis Hamilton qui se font un câlin. Voici le résultat après plusieurs itérations. Oui, c’est dégueulasse. Y’a des trucs malaisant. Désolée si vous étiez en train de manger. :’D Ici encore, le point faible, ce sont les données. Sur cette image, avec les copains, on soupçonne Midjourney d’avoir utilisé des morceaux d’un autre pilote pour recréer Max Verstappen : Charles Leclerc. Alors pourquoi ça fait ça ? Et bien, toujours pour la même raison. Midjourney et ses semblables utilisent des couples image/description pour s’entraîner et pour des pilotes de F1, nul doute qu’elles vont piocher les descriptions dans les articles de presse associés aux photos des pilotes ou les hashtags d'Instagram. Sauf que, ces IA, elles sont un peu con con quand même. Charles Leclerc et Max Verstappen sont deux pilotes qui se connaissent depuis tout petits à batailler en piste depuis le kart jusqu’à la F1, il est donc impossible de parler de l’un sans parler de l’autre. Par conséquent, les IA ont trouvé des photos de Charles Leclerc associées au nom de Max Verstappen. Et ne parlons même pas des tas de pécores sur Instagram qui ajoutent des tonnes de hashtag à la pertinence discutable sur leurs publications. ¬¬ Sans oublier les photos où les 2 pilotes sont présents. Résultat, les IA pondent des images de Max Verstappen en prenant des bouts de Charles Leclerc. Et patatra ! Ça donne ce genre de truc étrange… Avec une bouche à l’envers qui bave. 😂 Spartan pense que tous ces défauts seront gommés avec le temps. Voici ce qu’il faudrait faire pour y parvenir : Le fait est, que sur internet, la majorité des images que l’on trouve n’est pas associée à une description exacte de ce qu’elle affiche, et c’est la principale limite qui empêche d’aller plus loin. Pour contourner cette limite, il faudrait renoncer au crawling automatique du contenu du web et recruter des armées entières de gens qui rédigent une description exacte de chacune des milliards d’images utilisées pour entraîner les IA. … On parle de boîtes qui ne sont même pas fichues de recruter assez de monde pour cliquer sur un bouton “Supprimer” à la chaîne pour modérer les contenus haineux et qui sont même en train de licencier du monde en ce moment parce que leurs revenus sont en baisse (Coucou Meta ! ). ¬¬ Le nerf de la guerre, ce sont les données, leur quantité ET leur qualité. Faire avaler des pétaoctets de données à une IA ne sert à rien si on ne les nettoie pas et ne les traite pas avant. Et si elles sont trop chaotiques, il faut se taper le boulot à la main. Stratégie pour hacker les IA Ces IA donnent du pouvoir au camp des clients, mais en s'intéressant au fonctionnement du deep learning et aux cas de fiascos connus on peut se rendre compte que nous aussi, les artistes, avons un certain pouvoir. On peut pointer du doigt les activistes d’extrême droite pour leurs valeurs discutables mais on peut aussi les remercier de nous avoir montré la voie pour mettre du poil à gratter à ces entreprises qui utilisent nos images sans nous demander notre autorisation. Il suffit pour cela de s’attaquer au principal point faible des IA : en sabotant les données ! Voici plusieurs pistes pour ce faire. La première : comme expliqué plus tôt, il y a des trous dans les données qui font que les IA ne savent pas tout faire. Et bien on peut agrandir ces trous volontairement, en arrêtant de poster des portraits et des poses basiques, en nous efforçant de dessiner davantage de poses et de cadrages complexes (c’est pas un mal, ça nous fera progresser 😛 ) et lorsque nous postons nos images, ne surtout pas rédiger de description précise de leur contenu et réduire le nombre de hashtags aux seuls 2 ou 3 les plus pertinents. Ainsi, les IA n’ont aucune chance d’apprendre correctement l’anatomie et la perspective. La seconde : injecter de la merde. Les gens qui mettent des tonnes de hashtags à la pertinence discutable sur Instagram, finalement ils sont pas si cons. Petit exemple : Imaginons que vous dessiniez un Sangoku, seul, en train d’exécuter un Kaméhaméha. Lorsque vous postez l’image sur le net, premièrement, ne décrivez toujours pas la pose et le cadrage exact. Par contre, vous pouvez vous amuser à raconter ce qu’il se passe hors champ, des choses qu’on ne voit pas dans l’image, sans préciser que c’est hors champ (le visiteur humain le comprendra tout seul). Par exemple, que Sangoku va jeter son Kaméhaméha sur Végéta, ou Freezer, ou Cell… Et dans les hashtag ajouter des personnages qui n’apparaissent pas dans l’image, genre #vegeta #cell #freeza #gohan… Ou d’autres hashtags avec un lien éloigné. Comme ça, les IA seront dans la confusion. On peut même pousser le vice en associant ces hashtags à des contenus NSFW. 8D L’idée c’est de rendre le traitement des données impossible de façon automatisée et trop coûteux à la main. Si on s’y met massivement, il y a moyen de geler la progression de ces IA. A titre individuel, il n’y a pas grand chose à faire, juste être un peu attentif à la manière dont on décrit nos images quand on les poste sur Internet, voire être carrément flemmard et en écrire le moins possible. x) Plusieurs IA basées sur le contenu du web ont été sabotées de cette manière par le passé, parfois jusqu’au retrait du marché, donc il n’y a pas de raison qu’on ne puisse pas recommencer. La chose importante à garder en tête c’est que ce qui coûte le plus cher dans le développement d’une IA c’est la récolte, le nettoyage et le traitement des données et on peut rendre ça déraisonnablement cher. Alors en effet, je suis très sarcastique à propos des IA similaires à Midjourney. D’une part je suis assez fatiguée des discours binaires type “On va tous mourir” ou “C’est fantastique ! C’est la révolution !” qui survendent ces IA. D’autres part, j’en ai testées un certain nombre et je les ai trouvées tout à fait inexploitables pour mes projets et mes workflows. Je ne dis pas que ça ne servira à personne, mais ça ne colle pas à mes besoins spécifiques, voilà tout. Pour autant, je ne crache pas sur la technologie du Deep Learning en elle-même. Au contraire, je la trouve super intéressante, mais je vois sa place davantage pour des tâches exécutives spécialisées que pour des tâches créatives généralistes. Bon, maintenant qu’on a vu comment ça fonctionne, abordons la partie fun de l’article. Faire une IA soi-même ! \o/2 points

-

2 points

-

2 points

-

Travail sur le bâton magique de madame ! J'ai pensé à un squelette, au service de Sviktan qu'elle contrôlerait grâce à ses grimoires. Il serait enfermé dans son bâton, et sortirait quand elle le souhaite. Il n'y en a qu'un apparent, mais Dieu sait combien elle pourrait en invoquer. N'hésitez pas à me donner vos avis.2 points

-

Salut @Sunni.llu, bienvenue sur le site. Je partage comme toi et @Chazla violence qu’on se fait à soi même pour échanger. Mais il y a un super accueil et le partage est primordiale pour progresser. Hâte de voir tes œuvres et ta progression.1 point

-

Salut @DavidDantan, bienvenue parmi nous ! Tu as de belles ambitions qui te permettront de t'accrocher aux exercices et à la pratique. Et je n'ai aucun doute sur le fait que tu y arrives avec de l'organisation et une pratique régulière 🙂 En tout cas, je te souhaite plein de succès et me réjouis de voir d'autres de tes créations, celle-ci est déjà super cool ! 🙂 A très vite !1 point

-

1 point

-

Salut @tonysonictheone, il me semble que la fermeture de la chaussure ne devrait pas être collée sur le bord, mais un peu décalée vers la droite, pour mieux correspondre à la perspective1 point

-

1 point

-

Juste... WOAW.👏 Impressionnant tout ce travail fourni pour nous en apprendre plus sur les IA, une vraie mine d'or, je fais partager 😉 Chapeau ta "petite IA", elle me semble bien sympathique. Si j'avais un peu plus de temps à y consacrer, je m'y serai clairement mise, bien qu'il me faille sans doute une petite remise à niveau en maths ! 😂 Tiens nous au courant de ton avancée en tout cas ! Un grand merci, ça doit en rassurer plus d'un, je sens qu'on va voir pleuvoir des Winny l'Ourson / Sangoku dans les hashtag maintenant !1 point

-

1 point

-

1 point

-

Merci @Lionel Art pour tes retours ! Bien noté pour l'épaisseur des traits vis-à-vis de la proximité ou l'éloignement. Pour le crénelage bizarre, c'est sans doute dû à un coup de brush peu confiant mais j'ai aussi remarqué après coup que mon brush était mal réglé, avec un espacement trop grand. Enfin, je sais que d'avoir posté tout ça d'un coup n'est pas idéal, d'ailleurs avec tous les retours que j'ai eus, j'ai plein de choses à revoir je pense...je vais être plus régulier dorénavant.1 point

-

1 point

-

1 point

-

Effectivement ça fait plus doux et plus réaliste après du coup je verrai si je refais l'expression ou pas, le poussin vénère me fait rigoler un peu aux vues de comment l'exercice des oisillons fait parler de lui xD1 point

-

Hello à tous, Ça faisait un moment que je n’avais pas posté sur le forum... Donc voilà, c'est avec beaucoup de stress, de réflexion... mais aussi d'excitation que je me suis enfin décidé à passer le cap et publier un webtoon sur canvas (haha, un projet qui traîne depuis maintenant 3-4ans sur mon trello). D'autant que le concours tombait au même moment (ce qui m'a d'autant plus motivé oui...) Pour ce qui ne connaisse pas, il s'agit d'un format de BD à scroller qui sort par épisode (hebdo, tous les 15j etc..) et optimisé pour smartphone. Du coup je vous mets le lien ici pour découvrir le premier épisode : webtoon - PhaZeurs Bonne lecture !1 point

-

1 point