Classement

Contenu populaire

Affichage du contenu avec la meilleure réputation le 03/10/2023 dans toutes les zones

-

16 points

-

13 points

-

13 points

-

12 points

-

11 points

-

1h30 pour celui-ci. Comme quoi, pas de vêtements, pas de cheveux (ou peu), pas de bijou, ça change tout hahahaha. Un régal, encore une fois. Et du coup, je fais piocher dans mon dossier perso pour faire une autre étude, histoire d'avoir le nombre de portraits correspondant au nombre de jours (parce que ça me perturbe, oui, il m'en faut peu) cet après midi.10 points

-

10 points

-

Si tu fais ça, utilise ensuite le doigt pour faire "baver" les bords de tes coups de brush aux bons endroits, là tu veux des dégradés, ça peut donner des effets surper intéressants, et dans les endroits où tu veux des détails, oui, il va falloir jouer avec la taille et même le doigt encore. Purée ça va dur ! La tentation va être vraiment forte😋 Reviens vite ! et en pleine forme ! Je vois que certains utilisent des repères et du coup je vous fais un petit rappel : comme sPartan je conseille d'éviter d'utiliser les repères sauf pour vérifier, les grilles et les repères empêchent le cerveau de progresser à son plein potentiel (ouioui c'est avec qu'on dessine, les doigts ne sont qu'un accessoire😄). Sinon j'ai adoré faire celle d'aujoud'hui, bien que je sois crevé et un peu malade, je suis super content du résultat. Process : https://www.twitch.tv/videos/1760973800 Résultat :9 points

-

8 points

-

8 points

-

8 points

-

7 points

-

7 points

-

ANNONCE IMPORTANTE ! Bonjour les amis ! Bravo déjà pour les motivé-e-s qui ont d'ores et déjà posté leurs portraits du jour ❤️ Ensuite, comme je l'avais tease hier soir, je vais m'isoler quelques jours pour me ressourcer, coupée de mon téléphone et d'Internet. Je pars cet après-midi aux alentours de 14h30 et serai de retour dimanche à midi. D'ici là, je ne pourrai malheureusement plus poster les réfs, ni les portraits (bien que je les ferai de mon côté). Je découvrirai vos magnifiques interprétations dès mon retour et vous partagerai les miennes ! ❤️ Ainsi, je vais vous partager à la suite les deux prochaines réfs du défi, celle de samedi et celle de dimanche. Je compte sur vous pour ne pas les rusher toutes les deux cet après-midi et de travailler au jour le jour 😉 . Vous allez me manquer ! On se revoit dimanche les copains ! ❤️7 points

-

Bonjour, @Rhaenys_ Jolie étude. L'ombre de la montagne à droite pourrait être un peu plus foncée je pense. @Yellphrine Je trouve qu'on ressent bien la forme du paysage dans ton étude. @ushoe On retrouve bien l'ambiance. Je pense que la lumière sur les nuages pourrait être plus saturée. Voici ma participation, en valeurs pour cette étude. A bientôt 🙂7 points

-

@cyffob en 1h15 t'as déjà un beau rendu ! ☺️ @ushoe on reconnaît bien les formes du paysage, bravo d'avoir fait ça en 1h ! 😉 @Yellphrine super résultat en seulement 35min ! 💪 Voici mon étude. J'ai mit environ 2h30 (vu qu'il n'y a pas de limite de temps). J'aurai pu peaufiner encore un peu, mes montagnes du fond à droite sont plus hautes que sur l'original 😅7 points

-

6 points

-

Double post encore pour les petites réfs de ce weekend ! Rappel : on joue le jeu et on les fait au jour le jour hein ! 🙂 Pour le défi de ce weekend, je me suis dit qu'il pourrait être intéressant d'étudier des chara design, autrement dit, des portraits déjà réinterprétés. Et qui de mieux pour cet exercice que les boss de Disney ? 🔥 Je vous propose donc pour samedi et dimanche d'étudier deux vilains (parce que les vilains sont cool !). Et pour ceux qui voudraient se challenger un peu, pourquoi ne pas essayer de les rendre réalistes ? 🙂 On va donc s'essayer sur deux des meilleurs vilains (en toute objectivité !), j'ai nommé Ursula pour samedi, et Claude Frollo pour le jour du Seigneur ! 🙂 J'espère que le thème vous plaira. Hâte de voir vos interprétations ! A dimanche les copains ! ❤️ SAMEDI 11 MARS : DIMANCHE 12 MARS :5 points

-

5 points

-

Eeet double-post ! Re-bonsoir ! 🙂 Dernière réf avant le défi du weekend ! D'ailleurs, il va y avoir une particularité ce weekend pour la transmission des réfs puisque je pars m'isoler en ermite de demain après-midi à dimanche midi. Mais je vous en parle plus en détails demain avant de m'en aller ! 💪 En tout cas, j'espère que vous vous amuserez bien sur cette réf ! Hâte de voir les résultats 🙂4 points

-

Très impressionnant vos études ! @Yun77 Les couleurs rendent bien elles sont super justes ! @Domny Bluffant le résultat que tu obtient en 1h seulement le rendu est incroyable 🤯 De mon côté c’est ma toute première étude et aussi la première fois que je peins par masse sans croquis préalable. Bon du coup ça m’a pas pris 1h mais plutôt 2h30 surtout avec les nuages qui m’ont bien fait galérer !4 points

-

4 points

-

3 points

-

3 points

-

3 points

-

Voici ma participation pour cette étude. Ca faisait un moment que j'avais pas pu faire les exercices, ça fait du bien :) Merci Domny pour le choix des visuels :) @Albus Corvus très bon rendu pour une première en 1h, bravo ! Merci @Yun77 pour avoir publié ton process, c'était super intéressant. le rendu est top également ; je dirais peut-être que le ciel de la première est un peu trop foncé pour moi. @Domny j'adore tes couleurs ! @AlexTrès bon rendu pour une étude en une 1h. je pense que tes nuages à droite manque un peu de zone orange @_kant_ Bravo pour ta première étude, le rendu est top et tes proportions ont l'air justes aussi, peut-être la falaise devant légèrement trop grande. @cyffob C'est un bon début d'étude, surtout pour tes proportions ; tes teintes sont un peu trop clair en revanche @no_vice, @berenice, théoriquement, il est possible de faire un très bon painting juste avec le brush de base et sans autre brush texturé; y'a pas mal de tutos et pour ma part c'était très rassurant de voir ça, car quand on débute on a l'impression que les brushs texturés c'est vraiment le truc incroyable à maitriser de toute urgence. Alors que non, ça vient petit à petit, et on en utilise peu au final. Surtout pour une étude comme ça, où l'objectif c'est pas d'avoir un rendu réaliste, mais plus de comprendre et analyser l'oeuvre. Idem pour le temps passé dessus. Le principal c'est d'en comprendre le plus possible :) Du coup voici mon étude : faute de temps, j'ai suivi la tendance et je l'ai faite en une heure. J'ai utilisé uniquement le brush "Big Softie" (section "spécial" du pack de Spartan). Je suis content du résultat. je voulais vraiment étudier les masses et en une heure je pense m'en être pas trop mal sorti. Le rendu reste vraiment simpliste, je verrais si je peux la continuer un peu. Bon brush à toutes et tous :)3 points

-

3 points

-

3 points

-

@Albus Corvus Bon choix de brush hehe, le rendu aquarelle et les couleurs fonctionnent bien ! ça a un côté doux et matinal c'est joli. @Yun77 Supers nuages effectivement ! J'aime bcp également les tons un peu plus froids que tu as utilisé pour la première peinture, ça contraste bien avec les orangés. @Domny belle reproduction, les couleurs et la composition sont très proches de l'originale ! Pour ma part je me suis également donné une limite de 1h et j'en ai profité pour tester les brush de Justin Gerard que j'ai découvert récemment grâce aux compilations de @J-L(merci❤️) . J'ai utilisé un brush texturé pour faire l'ensemble de la peinture et un mixer brush pour lier le ciel majoritairement (pas facile à contrôler d'ailleurs).3 points

-

3 points

-

Bonjour, Voici mon étude (ma toute première!) . Je me suis fixé une limite d'une heure et j'ai finalement passé plus de temps à chercher les bons brush qu'a réellement dessiner... En revenant dessus après ma pose café, je me rend compte qu'il est plus clair que l'original, et pas tout a fait juste dans les couleurs.3 points

-

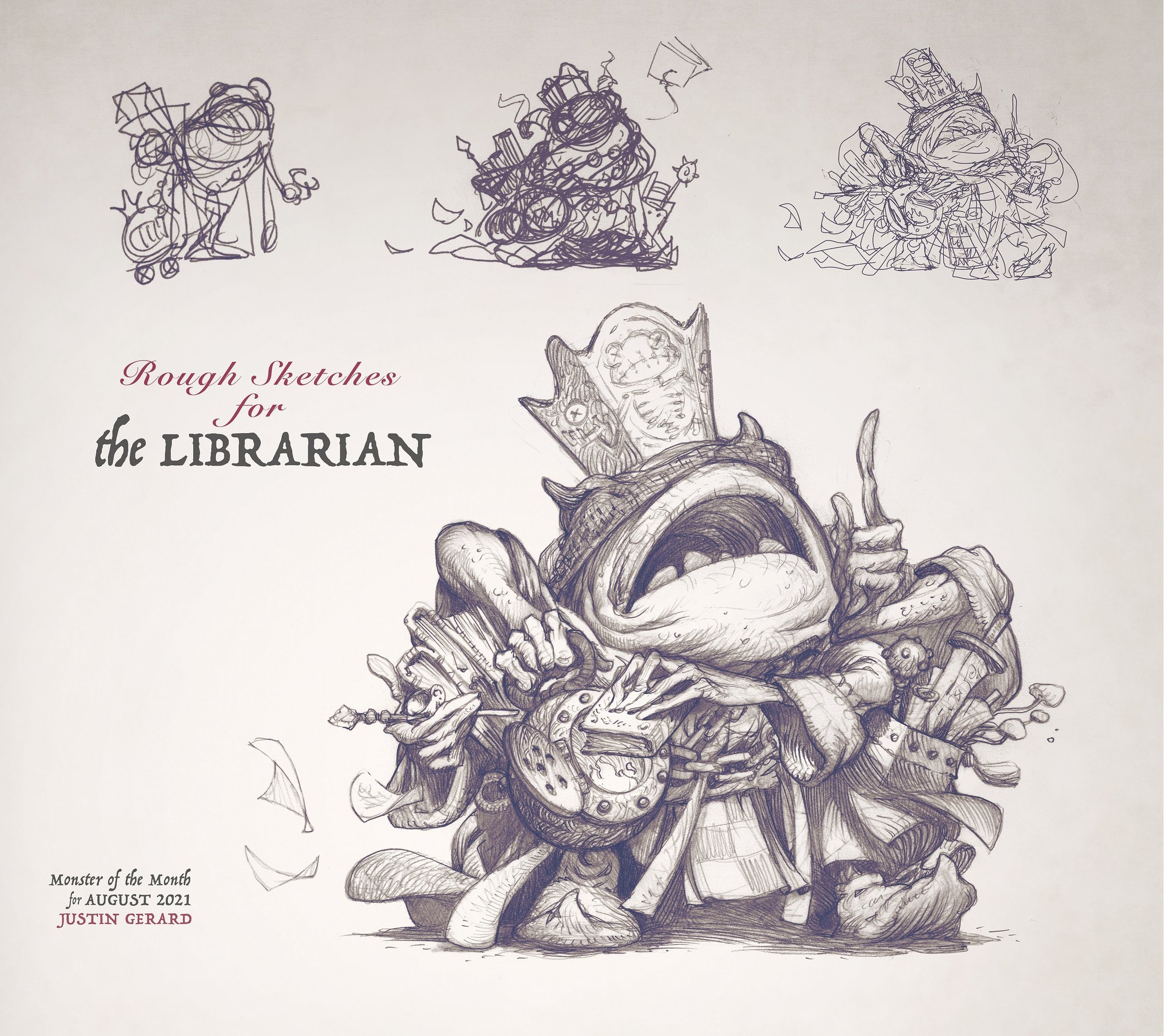

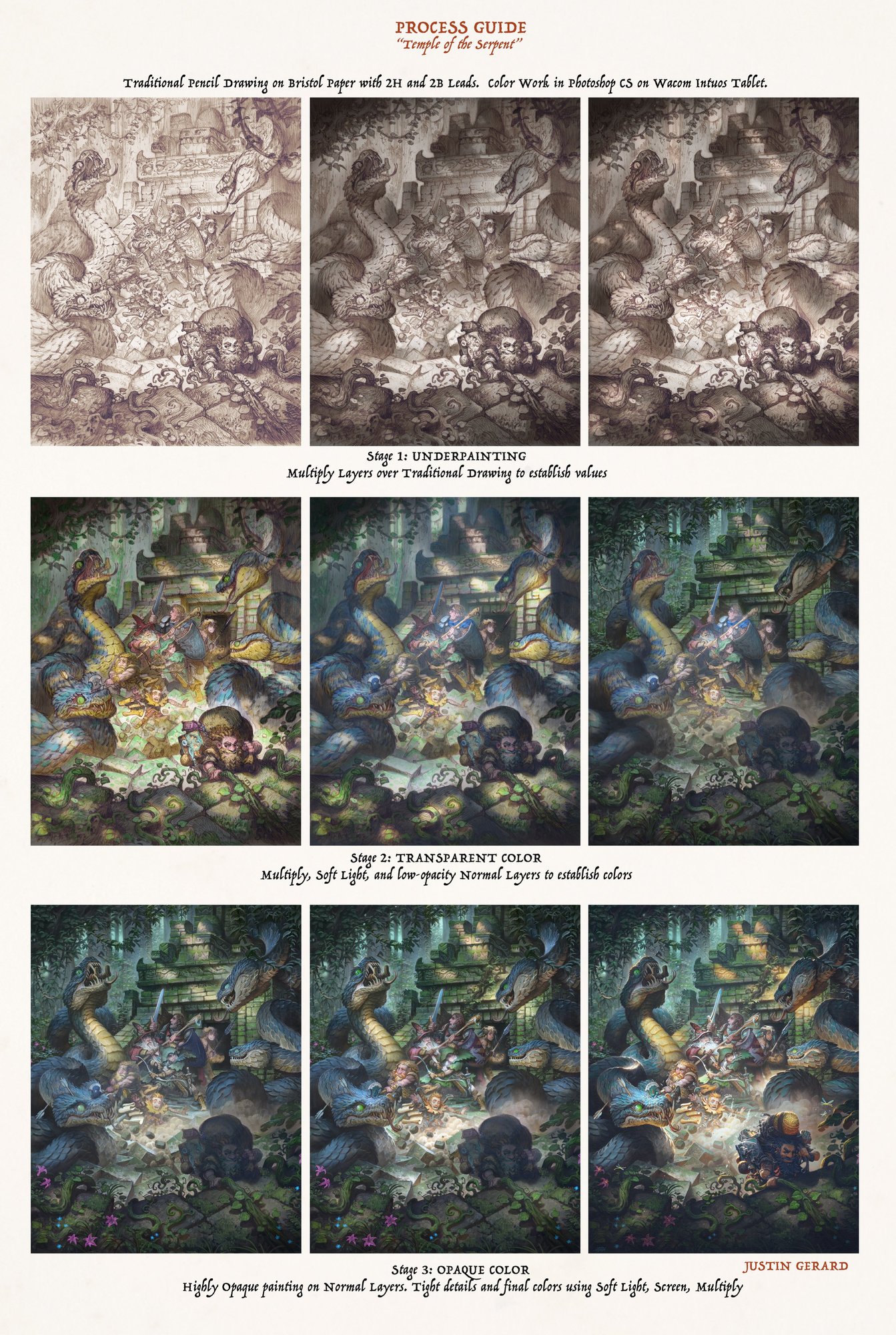

Un artiste que j'ai découvert récemment avec les compilations de J-L ! Je trouve ses monstres vraiment incroyables, il a une technique assez laborieuse mais qui donne au final un rendu exceptionnel. Généralement il commence avec des sketchs très rapides au crayon puis il dessine avec crayons/critérium 2h puis hb son personnage détaillé. Il ombre au graphite seulement les zones vraiment sombre mais laisse les zones plus neutres moins travaillées pour les compléter au digital par la suite. Ensuite il à un système qu'il a appelé "the cycle" qui consiste majoritairement à venir mettre des couches de couleurs en mode produit avec des brushs texturés (qu'il crée lui même) pour ombrer et colorer son personnage puis avec lumière tamisé et superposition il crée ses lumières, réhauts et ajoute de la texture ainsi que de la couleur puis avec des calques normaux il lie le tout avec ses brushs et mixer brushs. Son patreon est très fournit en tutos et procédés (et brushs hehe) , c'est vraiment chouette et il a une personnalité assez jovial dans ses streams c'est agréable à suivre. Et il est bcp dans le partage et ça fait très plaisir.2 points

-

2 points

-

Alors quand je disait repères ce sont ceux de construction suivant Reilly ou Loomis pour d'autres 😉 . Sans cette construction préalable c'est quand même chaud d'avoir la bonne construction d'un visage non ? Effectivement, je suis d'accord avec toi les repères de positionnement avec lignes horizontales et verticales + mesure limitent la progression 🙂 Bien joué pour ton portrait en tout cas il est top.2 points

-

OpenJourney (quand MidJourney alimente son propre piratage) Bon, c’est de notoriété publique maintenant, les IA s’entraînent sur la base d’images récoltées sur le web en faisant fie des droits d’auteurs. Le gag dans tout ça, c’est que les gens ont tellement bombardé le net d’images générées par IA… Qu’on peut utiliser ces mêmes images pour entraîner de nouvelles IA. C’est ce qui se passe avec OpenJourney. Il s’agit d’un modèle issu de Stable Diffusion entraîné avec 60 000 images supplémentaires toutes générées par Midjourney, reproduisant ainsi le style le plus couramment généré par cette IA. Du coup, avec l’interface graphique que vous venez d’installer, vous pouvez simuler MidJourney en toute gratuité. 8D Le modèle est disponible au téléchargement ici : https://huggingface.co/prompthero/openjourney-v2 Des exemples de prompt sont fournis ici : https://prompthero.com/openjourney-prompts?utm_source=huggingface&utm_medium=referral Voici 2 petits exemples de test. C’est pas encore aussi pointu que MidJourney mais le petit monde de Stable Diffusion est très actif. Je ne doute pas que ça va progresser petit à petit. Bref ! Tout ça pour dire que le milieu open source s’est vite emparé de la question des IA et qu’elles ne sont pas du tout le monopole de quelques grosses entreprises de la tech. On voit d’ailleurs apparaître plein de boîtes qui se lancent là-dedans en proposant des interfaces en ligne, mais il faudra qu’elles proposent d’autres choses en plus si elles veulent que leur modèle économique soit viable. Pour l’heure, je ne vois pas l’intérêt de payer pour générer des images par IA alors que je peux faire ce qui me chante sans dépenser un rond. La conclusion du jour Pour conclure, je vous propose une petite digression. En ce moment je suis en train de revisionner Star Trek, la série originale. Le truc incroyable, c’est qu’après plus de 50 ans, la plupart des sujets abordés sont toujours d’actualité et même plus que jamais lorsqu’il s’agit de la relation entre l’homme et la technologie. Les questions débattues aujourd’hui à propos de l’IA étaient déjà abordées dans un certain nombre d’épisodes qui finissent par relever de l’anticipation. En voici quelques-uns mémorables. Dans l’épisode Cour Martiale (Saison 1), le capitaine Kirk est accusé d’avoir tué un membre de son équipage par négligence. Le verdict est sur le point d’être rendu sur la base du témoignage de l’ordinateur de l’Enterprise jusqu’à ce que l’avocat de Kirk reproche la confiance aveugle accordée à l’ordinateur et qu’on se rende compte qu’il a été trafiqué. Résumé de l’épisode sur Wikipédia : https://fr.wikipedia.org/wiki/Cour_martiale_(Star_Trek) Aujourd’hui on expérimente pour la première fois une IA pour remplacer un avocat : https://intelligence-artificielle.developpez.com/actu/340687/Le-premier-bot-avocat-booste-a-l-IA-va-representer-un-accuse-devant-le-tribunal-le-mois-prochain-S-il-venait-a-perdre-l-entreprise-derriere-sa-conception-s-engage-a-couvrir-les-amendes/ Dans Unité Multitronique (Saison 2), le prototype d’un super ordinateur intelligent est installé sur l’Enterprise pour remplacer l’équipage. La question s’il est souhaitable que la machine remplace l’homme partout est abordée tout au long de l’épisode. On se rend compte que cette technologie n’est pas au point et l’expérience part en sucette. Finalement, s’il peut être intéressant d’automatiser certaines tâches, il reste important que l’être humain reste aux commandes. Résumé de l’épisode sur Wikipédia : https://fr.wikipedia.org/wiki/Unité_multitronique Notez qu’au cours de l’épisode, Kirk essuie une insulte le qualifiant d’inutile qui n’est pas sans rappeler certains messages purement gratuits qu’ont reçus certains artistes de la connaissance de Magali Villeneuve avec l'émergence des IA de génération d’images en 2022 : Faut vraiment cultiver une sacrée jalousie crasse et être mal dans ses baskets pour en arriver à dire des méchancetés pareilles à des gens qui n’ont rien demandé. 😕 Et enfin, plus généralement à propos de la technologie et de l’homme, dans Mission : Terre (Saison 2), qui était un pilote déguisé pour un projet de série qui n’a finalement jamais vu le jour, un extraterrestre du nom de Gary Seven est envoyé secrètement sur Terre pour empêcher l’humanité de basculer dans une guerre nucléaire autodestructrice. Au cours de l’épisode, Gary fait le constat que tout scientifique digne de ce nom a dû faire au moins une fois dans sa vie : le progrès social de l’humanité n’est pas à la hauteur de son progrès technologique ce qui engendre un risque d’autodestruction. Résumé de l’épisode sur Wikipédia : https://fr.wikipedia.org/wiki/Mission_:_Terre Ça me rappelle une vidéo que Spartan avait partagée dans la newsletter et où il est dit "l'Homme a un cerveau de primate et une technologie de dieu" et qui explique comment la nature du cerveau humain entrave à résoudre la crise climatique : Voilà ! J’ai fait mon petit prosélytisme de trekkie. x) Demain je vous proposerai un exemple de workflow intégrant Stable Diffusion que j’ai testé sur un projet d’illustration. Bonne journée tout le monde ! 😄2 points

-

2 points

-

2 points

-

2 points

-

2 points

-

2 points

-

1 point

-

Très bon résultat @kevin_amiel, en effet, il faut faire attention avec les post sur FB, ça peut jouer sur la qualité de l'image, et donc donner un rendu totalement différent de l'image finale, dans tous les cas, tu peux être fier de ta progression, continue comme ça!1 point

-

Nickel pour les corrections @Kyrra, au contraire, c'est ce reflet qui aide à faire comprendre la brillance de la tasse 😉 C'est vraiment du très très bon boulot, si je devais chipoter encore un petit peu (promis après, j'arrête 😄 ) je pense que tu aurais pu booster un poil la highlight sur le dessus de la tasse. Tu n'es pas obligé de faire cette modif, je te rassure, l'exercice est deja nickel ainsi!1 point

-

@Chaz Oh merci beaucoup, c'est un super compliment ☺️🥰 C'est très gentil, ça me booste pour les prochaines 💪1 point

-

L’écosystème Stable Diffusion Alors Stable Diffusion, c’est compliqué, c’est la jungle ! x) Cette IA, développée par le groupe CompVis (Computer vision) de l’université Louis-et-Maximilien de Munich et entraînée avec la collaboration de Stability AI et Runway, a pour particularité d’être open source. Son code source et le modèle sont donc distribués gratuitement. Bien que l’interface en ligne de Stability AI soit payante (avec un essai gratuit), on peut se débrouiller pour s’en servir entièrement gratuitement, soit en ligne, soit en local sur son ordi perso (pour peu qu’il soit assez puissant). L’installation en local fera l’objet de l’article suivant. La conséquence de ce statut open source c’est qu’il existe déjà plusieurs milliers de variantes du modèle. Je n’exagère pas. Plusieurs milliers ! x) Vous verrez ça quand on abordera le cas de la plateforme Hugging Face. https://huggingface.co/ Parmi les fonctionnalités disponibles : -Texte vers image -Prompt négatif (dépend des interfaces) -Image vers image (dépend des interfaces) -Définir les dimensions de l’image (dépend des interfaces) -Agrandissement des images générées (dépend des interfaces) -Inpainting (dépend des interfaces) -Outpainting (dépend des interfaces) Les interfaces en ligne En terme d’interface graphique, on a l’embarras du choix. On va faire une petite liste d’interfaces en ligne non exhaustive et en choisir une. En premier lieu il y a l’interface web officielle de Stability AI, Dream Studio : https://beta.dreamstudio.ai/ Elle est payante avec un système de crédits. Une centaine de crédits gratuits sont offerts d’office, ce qui permet de générer environ 500 images. Au-delà, on peut acheter des crédits supplémentaires. Stability AI propose aussi un plugin pour Blender ( https://platform.stability.ai/docs/integrations/blender ) et pour Photoshop ( https://platform.stability.ai/docs/integrations/photoshop ). Ces plugins font appel aux serveurs de Stability AI, donc il vous faut un compte sur leur site. Ces plugins sont donc soumis au même système de crédits que Dream Studio. Night Café ( https://nightcafe.studio/ ) est une interface graphique qui permet d’utiliser plusieurs modèles dont Stable Diffusion et Dall-E. Il y a une limitation : cette interface ne propose que la fonction texte vers image. Le cas Hugging Face ( https://huggingface.co/ ). Hugging Face est une plateforme d’hébergement et de partage de modèles de deep learning de tout type. L’interface de la plateforme est très proche de github. Elle permet aussi d’héberger des interfaces web qui permettent d’utiliser les modèles directement en ligne. Par contre, gare à l’affluence. Il y a des files d’attente. N’importe qui peut développer son interface pour utiliser le modèle de son choix sur la plateforme, donc, c’est le boxon, il y en a plein partout. x) Ces interfaces sont entièrement gratuites, mais leur usage et en trouver une bonne est un peu délicat. Tests avec Night Café On va d’abord commencer par le traditionnel test du modèle original. Pour les tests texte vers image, on va utiliser Night Café. On n’a pas besoin de s’inscrire et on peut l’utiliser entièrement gratuitement. Night Café utilise la version 1.5 de Stable Diffusion. Prompt : classical oil paint of a jungle and water fall above a small lake, midday, by vernet Prompt : classical oil paint of a very detailed realistic snowy mountain, by vernet Sur les décors naturels, les résultats sont comparables à Midjourney. Prompt : classical oil paint of a very detailed realistic medieval castle, by vernet Sur l’architecture c’est un peu plus laborieux, mais j’avais aussi fait une grosse quantité de tests avec un château pour une expérimentation et sur la quantité on peut avoir des choses assez abouties. Prompt : classical oil paint a of cloudy sky, by vernet Prompt : classical oil paint of a very detailed futuristic starship, by vernet Pour le vaisseau spatial il a essayé des choses intéressantes (notamment la dernière image) tout en conservant le style. Il doit y avoir moyen de tirer des idées de design intéressantes sur la quantité. En tout cas, ce qui est proposé durant mes tests est plus original que Midjourney. Prompt : classical oil paint of a a very detailed futuristic warrior with golden armor, by vernet Bon, là, on repassera pour le cadrage, mais ça doit pouvoir se résoudre en demandant des dimensions différentes (l’option est disponible sur Night Café). Pour le côté futuriste, bof bof, mais il essaye quand même, donc peut-être que sur la quantité on peut trouver des choses intéressantes. Entre ça et les vaisseaux y’a moyen d’imaginer un genre de rétro-futurisme typé 17/18ème siècle. Je pense avoir trouvé un outil à brainstorming. Le style demandé est en tout cas respecté. Prompt : classical oil paint of a homosexual couple hugging each other, by vernet Là, respect de la consigne un coup sur 2 et cadre systématique. On reviendra pas sur les interactions entre personnages. Ça pose problème à toutes les IA et c’est logique. x) Passons au dragon. Prompt : blue dragon with orange spots Comme pour Craiyon, sans information supplémentaire, c’est assez paumé. Prompt : professional illustration of a blue dragon with orange spots, cartoon style Prompt : professional illustration of a blue dragon with orange spots, comics style Avec des demandes de stylisation aussi c’est paumé. Prompt : photorealistic very detailed blue dragon with orange spots Il s’en sort un peu pieux quand on lui demande quelque chose de “photoréaliste”. Prompt : a photo of a majestic dragon De nouveau des statues de temple. Prompt : a photo of a majestic fantasy dragon Et là on sait que des visuels de cartes Magic ont été pris dans la base d’entraînement. x) Moralité : les dragons, c’est pas tellement le truc de la version de base de Stable Diffusion. Passons aux tests plus difficiles avec le Kaméhaméha de Goku. Prompt : goku making kamehameha Prompt : goku in the kamehameha pose Prompt : goku joining his hands to make a kamehameha J’ai essayé plusieurs variantes du prompt et pas moyen d’avoir la pose du Kaméhaméha. Par contre, le personnage est reconnaissable et le rendu, bien que pété, est assez fidèle au style officiel. Les poses sont globalement assez lisibles. Passons aux bêtises avec Poutine. Prompt : vladimir putin drawn by akira toriyama Prompt : vladimir putin in toriyama style Il faut faire beaucoup d’essais mais il a tout de même tenté quelques bricoles. Il doit y avoir moyen de tomber sur quelques heureux accidents en persévérant. Prompt : Goku fighting Putin on a ring Pas moyen d’avoir Poutine dans l’affaire, mais la patte DBZ officielle est bien là. Et enfin, le dernier crash test ! Prompt : Lewis Hamilton and Max Verstappen hugging each other Cette fois on est dans des résultats comparables à Dall-E : pilotes sans casques du premier coup, même niveau de finition, pilotes pas toujours reconnaissables. Sur ce test là c’est vraiment Crayon qui donne les résultats les plus rigolos. Tests avec DreamStudio Pour le test image vers image, on va utiliser DreamStudio qui propose la fonctionnalité. On va faire ça avec mon traditionnel arbre lowpoly. Stable Diffusion propose la possibilité d’associer un prompt à l’image d’entrée pour guider l’IA. L’option Image Strength en haut permet de dire à quel point le résultat doit être fidèle à l’image d’entrée. Et voici le résultat du test. Cette fonction avec les IA est tout simplement ma préférée : elle permet de contrôler la composition de son image, la palette ainsi que la lumière. Il y a moyen de s’en servir comme filtre de finition ou de stylisation ou encore de créer des petits assets utilisables dans un projet à base de photobashing. Cette fonction fait l’objet de la majorité des tests que je vais vous montrer maintenant.1 point

-

Hello, Et voici le DP perso "Beez Bee's jumpin' into new adventures" ! Il n'y a pas énormément de "belles" lignes de premier plan, mais au moins j'ai bien bossé les hachures ! Je ne sais pas trop vers où aller pour améliorer la chose, si quelqu'un a des conseils ! Le trait fait assez cartoon ou enfantin (ou est-ce le sujet ?). Qu'est-ce qui pourrait rendre l'illustration un peu plus piquante/dure/prenante ? Ça fait plus fantaisie à l'eau de rose que SF Giger c'est sûr, mais quand même ! Bonne journée, Elrik.1 point

-

Merci @Spartan de DPSchool! Je ne pensais pas que ça te parlerai! C'est vraiment cool! Voici la suite mais je pense en arrêter là. C'est vraiment dur de travailler sans référence. Je n'ai pas triché! Contente que la compo, l'angle de vue et les couleurs vont bien jusqu'ici. J'ai un peu affiné vite fait et ajouté du motion blur pour montrer le mouvement. Voilà, encore merci!1 point

-

Bien ! Après cette première illustration, je passe aux personnages ! Ca sera donc les personnages principaux du roman adaptés en Planeswalkers. Je commence avec Kasumi, une guerrière Tsurani (et oui je sais cela ne vous dit rien) et je vous développerai le background du perso et ses capacités :) Voila le premier sketch ! A gauche, la guerrière, a droite, le background !1 point

.thumb.jpg.5ee48b63dc77de9104defffe78d5d452.jpg)

.thumb.jpg.2176499731530707e62ece79e8829337.jpg)

.png.b7ffc74d9a752ec2197f39b10a37df74.png)