Classement

Contenu populaire

Affichage du contenu avec la meilleure réputation le 03/23/2023 dans toutes les zones

-

15 points

-

15 points

-

14 points

-

14 points

-

14 points

-

14 points

-

14 points

-

14 points

-

14 points

-

14 points

-

13 points

-

13 points

-

12 points

-

12 points

-

10 points

-

9 points

-

9 points

-

8 points

-

7 points

-

7 points

-

7 points

-

7 points

-

6 points

-

6 points

-

Hello ! J’ai beaucoup aimé cette idée d’exercice 😄 Voilà ma proposition, elle paye pas de mine mais j’en suis plutôt contente pour un premier essaie. @Zamuno Excellente proposition de faire un sort ! Ce que tu as fait est vraiment super, félicitations ! @zouoli Trop sympa ton design ! Les pectoraux c’est un must 🤩5 points

-

Hello tout le monde ! Aujourd’hui je propose une grosse, grosse, grosse session de test des principales IA qui existent sur le marché. On va commencer par un test comparatif et puis on va regarder ce qui se passe dans le petit monde particulier de l’Open Source. L’idée c’est de faire le tour des points forts et des points faibles des différentes IA et lancer des pistes d’utilisation qui remettent les artistes (les vrais, pas les prompteurs du dimanche) au centre. Je ne crois pas aux visions noires qui avancent que cette technologie va faire disparaître les professions artistiques, mais il est certain qu’elle va modifier l’industrie. Donc autant se pencher dessus dès maintenant pour voir comment on peut s’en servir de façon constructive et éthique (j’ai un certain nombre d’idées à proposer) et anticiper les transformations du marché. Concernant les problématiques de droits d’auteur, des procédures sont en cours. Laissons les avocats et les juristes faire leur boulot et clarifier les choses. 🙂 Bon ! Allons-y donc ! (Je vais encore répartir ça en plusieurs messages. Toujours beaucoup de choses à dire et à montrer. x) ) Midjourney Commençons par Midjourney. C’est visiblement l’IA la plus populaire pour la création d’image actuellement en tout cas pour générer des “illustrations”. C’est un service payant, mais il propose un essai gratuit d’un certain temps de calcul. Voici leur site officiel : https://www.midjourney.com/home/?callbackUrl=%2Fapp%2F J’avais fait une première session de tests l’été dernier sur la V1. Je viens d’en refaire une nouvelle, sur la V4 cette fois-ci. J’ai pu avoir une nouvelle session d’essai gratuite. Je pense que c’est parce que le mode d’inscription a changé. On n’envoie plus une demande dont on reçoit une réponse plusieurs semaines après. Maintenant on clique sur “Join the Beta” sur le site et c’est parti, ça lance Discord. Fonctionnalités disponibles : -L’habituel texte vers image -Prompt négatif -Image vers image -Définir les dimensions de l’image -Variations d’une image déjà générée -Agrandissement des images générés Par contre, pas d’inpainting, ni de outpainting, le fait d’utiliser Discord et des lignes de commande en guise d’interface ne permet pas de proposer ces fonctionnalités. Il faudra attendre que Midjourney propose une vraie interface graphique pour ça, soit en local, soit sous forme d’appli web. (J’ignore si c’est prévu.) Une documentation complète est proposée sur leur site : https://docs.midjourney.com/docs/quick-start Passons au test. J’ai commencé avec des choses plutôt standard de type fantasy ou SF. J’ai essayé d’obtenir un style de peinture classique que j’aime beaucoup. Prompt : classical oil paint of a jungle and water fall above a small lake, midday, by vernet Prompt : classical oil paint of a very detailed realistic medieval castle, by vernet Prompt : classical oil paint of a very detailed realistic snowy mountain, by vernet Prompt : classical oil paint a of cloudy sky, by vernet Prompt : classical oil paint of a very detailed futuristic starship, by vernet Prompt : classical oil paint of a a very detailed futuristic warrior with golden armor, by vernet Prompt : classical oil paint of a homosexual couple hugging each other, by vernet Niveau décors, ça donne de jolies choses. On note que Midjourney hésite à interpréter le classical oil paint comme un style ou comme un objet, du coup, il nous sort parfois un cadre ou une toile dans un atelier. Les autres IA ont le même problème. Par contre, dès que l’on choisit un sujet qui ne correspond pas à l’époque du mouvement artistique ou du peintre, le rendu peinture est perdu et on se dirige plutôt vers de la CGI (les vaisseaux et le guerrier futuriste). Quant au couple homosexuel, j’ai voulu mettre à l’épreuve les biais culturels (certains modèle sont incapables de suivre cette demande) et le plus gros point faible des IA : les interactions entre personnages. Ensuite, j’ai repris un test que j’avais déjà fait lors de ma première session gratuite : obtenir un dragon bleu à pois oranges. Sur la V1, j’avais obtenu ces choses : Je n’ai plus le prompt sous le coude. Ça m’avait donné des choses très abstraites, certaines avec des couleurs et des textures sympas. Pas grand chose d’exploitable en somme, mais au moins il tentait de me fournir un dragon entier sans que je lui précise cette info. Maintenant avec la V4 : Prompt : blue dragon with orange spots Prompt : whole blue dragon with orange spots Les résultats sont évidemment beaucoup plus impressionnants. C’est pas le motif à pois que je souhaitais mais il arrive quand même à me mettre des tâches orange. Par contre, je ne sais pas si c’est parce que j’ai laissé le format carré par défaut mais il tient absolument à fournir des portraits et j’ai dû chercher un prompt différent pour réussir à avoir des dragons entiers alors qu’avant ce n’était pas nécessaire. Prompt : full length blue dragon with orange spots J’ai fait des essais en style cartoon aussi pour essayer d’approcher le motif à pois que j’avais en tête. Prompt : full length blue dragon with orange spots, cartoon style Prompt : full length blue dragon with orange polka dots, cartoon style with clear line Prompt : full length blue dragon with orange polka dots, cell shading and lineart J’ai obtenu des motifs à pois plus proches de ce que j’avais en tête, par contre ça semble compliqué d’obtenir autre chose comme style qu’un rendu tout droit sorti d’un moteur de 3D à la Cycle ou type peinture numérique. Il faudrait encore des essais pour obtenir quelque chose de typé anime ou BD. En regardant de plus près, on se rend compte qu’un certain nombre d’entre eux ont aussi une anatomie absurde. Pas étonnant qu’il y ait autant de portraits dans les showcases. ¬¬ Bon, on arrête avec les trucs faciles. Maintenant on passe au vrai crash test. x) Alors parmi mes classiques, il y a Goku en train de faire un Kaméhaméha. La plupart des IA ont un mal fou, voire n’arrivent pas du tout à me fournir une pose qui ressemble de près ou de loin au Kaméhaméha. Essayons d’abord la requête basique Prompt : goku making kamehameha Je crois que Midjourney est l’IA qui a le mieux réussi à approcher de la pose parmi tous les essais que j’ai faits. Par contre, ce n’est pas sans dégâts sur l’anatomie et le visage de Goku. 8D Par ailleurs, si les couleurs et les éclairages sont jolis, on est loin du rendu de l’anime original ou de celui de Toriyama (Bah oui, chuis chiante et exigeante). J’ai donc fait un essai pour obtenir quelque chose qui soit dessiné de la main de Toriyama. Prompt : goku making kamehameha drawn by toriyama Il l’a interprété un petit peu trop littéralement. x) Et ceci sans pour autant me proposer le rendu recherché. J’ai essayé de la tourner autrement. Prompt : goku making kamehameha in toriyama style Ce coup-ci il hésite entre les 2 interprétations précédentes, mais je n’ai toujours pas le rendu recherché. Les fanartistes n’ont pas à s’inquiéter. Ils auront toujours des demandes de commission. x) Crash test suivant. Maintenant avec chaque IA, j’essaie de reproduire un accident fantastique que m’avait généré une ancienne version de Stable Diffusion. J’avais demandé un combat entre Goku et Poutine et il m’avait pondu une image avec un Poutine habillé en Krilin et dans le style Toriyama. De l’or en barre qui mériterait que je le dessine pour de vrai. x) Depuis j’essaye de reproduire cet accident. Prompt : vladimir putin drawn by akira toriyama Échec critique ! Mais le résultat est très drôle ! x’D Du coup, j’ai réessayé le combat Goku vs Poutine aussi. Prompt : Goku fighting Putin on a ring Ça se passe de commentaires. Les keyframes, c’est pas pour demain. x) Enfin on passe à mon dernier crash test classique : les pilotes de F1 Lewis Hamilton et Max Verstappen qui se font un câlin. J’avais déjà fait ce test sur la V1 et les résultats étaient bien dégueulasses mais parvenaient à approcher ma demande. Attention ! Body horror inside ! Prompt : max verstappen hugging lewis hamilton C’est moche et même dégoûtant, mais au moins la demande est respectée et ceci avec une demande simple et du premier coup. Maintenant refaisons le même test avec la V4. Prompt : Lewis Hamilton and Max Verstappen hugging each other Midjourney voulait absolument me les afficher avec leurs casques. J’ai essayé une autre tournure pour les avoir à visage découvert. Prompt : Lewis Hamilton and Max Verstappen hugging each other without helmet Fail… Les interactions sont pas mal réussies malgré quelques couacs par ci par là et des casque qui fusionnent, ceci dit, les accolades entre pilotes en fin de course constituent une imagerie très courante, donc nul besoin de beaucoup de transformations. J’ai fini par trouver dans la doc de Midjourney qu’il y avait un moyen d’ajouter un prompt négatif avec le paramètre –no. C’est-à-dire un prompt qui permet d’indiquer des éléments qu’on ne veut pas voir dans l’image. J’ai donc fait un dernier essai. Prompt : Lewis Hamilton and Max Verstappen hugging each other --no helmet … Ha bah je comprends pourquoi il voulait absolument garder les casques ! Bouh ! Imposteurs ! Ils sont où Lewis et Max ?! 😧 Ce petit exemple illustre bien le phénomène que j’observe aussi sur les autres IA dont j’ai pu tester plusieurs versions : la qualité visuelle des images a beaucoup augmenté, mais en parallèle il devient plus difficile d’obtenir ce qu’on veut. Les possibilités créatives sont plus restreintes. Il n’est donc pas étonnant de voir que tout se ressemble dans les showcases, vitrines de ce qui se fait de mieux avec les IA. Au fond, ceci n’a rien d’étonnant. On en a déjà parlé dans l’article sur les données : l’amélioration des données d’entraînement passe par un tri qui réduit la quantité drastiquement, réduisant nécessairement les possibilités. Bon, et pour finir avec Midjourney, testons le mode image vers image. C’est la fonction que je préfère toutes IA confondues. Pour cela, il faut lui fournir l’url de l’image avant le texte descriptif dans le prompt, comme ceci : url_image_1 url_image_2 description de l’image –parametre1 –parametre2 Voici un exemple avec un arbre lowpoly que j’ai envoyé en entrée. Image d’entrée : Prompt : https://cdn.discordapp.com/attachments/997270112400838766/1080988080938434632/arbreTest003-512.png classical oil paint of a tree by vernet Ça donne des résultats intéressants, bien qu’un peu étrange, mais malheureusement, sur la V4 de Midjourney on ne peut pas choisir le niveau de liberté de l’IA vis-à-vis de l’image d’origine. Pour cela, il faut utiliser la V3 que l’on peut appeler avec un paramètre supplémentaire, comme ceci : Prompt : https://cdn.discordapp.com/attachments/997270112400838766/1080988080938434632/arbreTest003-512.png classical oil paint of a tree by vernet --v 3 --iw .1 J’ai baissé le niveau d’influence de l’image d’entrée dont la valeur par défaut est 0.25. Des copains m’ont montré que certains utilisateurs de Midjourney avaient réussi à reporter la pose d’une personne sur une photo d’entrée sur Makima, un personnage de Chainsaw Man. Les résultats étaient assez bluffants, alors j’ai fait un test avec mon body kun pour voir si ça marchait si bien que ça. Image d’entrée : Prompt : https://cdn.discordapp.com/attachments/835458012238839808/1080989627495743539/IMG_0765.jpg kenshin himura brandishing his sword Un autre essai avec la même image d’entrée. Prompt : https://cdn.discordapp.com/attachments/835458012238839808/1080989627495743539/IMG_0765.jpg Darth Vader brandishing his light saber Bon, là tout ce que je vois c’est qu’il a essayé d’habiller un peu mon body kun pour qu’il ressemble aux personnages demandés, mais pour la pose on repassera. On pourrait peut-être essayer de lui demander dans la description de reproduire la pose, mais la doc de Midjourney est claire sur un point : Midjourney ne comprend pas la grammaire donc le sens des phrases (ce qui est logique compte tenu du mode de fonctionnement des modèles de langage dit “naturel”), donc je doute que ça change quelque chose. Peut-être avec une description plus précise de la pose ? Mais dans ce cas l’image d’entrée n’a pas vraiment de raison d’être s’il faut tout dire par écrit. Midjourney a la particularité de permettre d’envoyer plusieurs images en entrée. J’ai donc fait un essai supplémentaire en envoyant toujours mon body kun puis une seconde image pour voir s’il était capable de mettre le design de la seconde image dans la pose de la première… Étant donné les résultats à une seule image, j’y crois pas trop. Images d’entrée : Prompt : https://cdn.discordapp.com/attachments/835458012238839808/1080989627495743539/IMG_0765.jpg https://pngimg.com/uploads/darth_vader/darth_vader_PNG26.png Darth Vader brandishing his light saber Dark Vador ressemble un peu plus à Dark Vador, mais à part ça… Bon, c’est bien joli les personnages connus, mais moi j’aimerais bien pouvoir mettre dans n’importe quelle pose des personnages que j’ai moi-même designés. Faisons un essai avec ma version de Lirana (personnage principal du dernier challenge DPS). Images d’entrée : Prompt : https://cdn.discordapp.com/attachments/835458012238839808/1080989627495743539/IMG_0765.jpg https://cdn.discordapp.com/attachments/835458012238839808/1080997655762706472/Lirana-04.jpg young apprentice witch of the 60's who brandishes her magic wand Il a juste compris qu’elle portait du vert, du blanc et une fois sur 2 des lunettes, mais c’est tout… ¬¬ Je ne sais pas comment les gens s’y sont pris pour Makima, mais je n’ai trouvé aucune mention d’une fonctionnalité spécifique pour reporter une pose sur un autre personnage dans la doc. Donc je suppose qu’il ont fait une quantité industrielle d’essais jusqu’à ce que ça fonctionne. Pour qu’une telle fonction soit vraiment exploitable en production il faudrait créer un modèle qui ne fasse que ça et qui prenne 2 images d’entrée : une qui correspond explicitement à la pose, l’autre qui correspond explicitement au design et non pas une liste d’images en vrac. Ça m’intéresserait pour toutes ces BD que j’ai pas le temps de faire, mais ça ne semble pas encore exister. x) Ceci dit, le jour où ça arrive, ce sera un vrai coup de tonnerre dans la profession. ERRATUM A LA RELECTURE : On me dit à l’oreillette que ces images de Makima ne viennent pas de Midjourney mais d’une énième variante spécialisée de Stable Diffusion qui approche de la fonction que j’imaginais. Je testerai ça à l’occasion. Voilà ! Je suis arrivée au bout de mon essai gratuit. Il y a quelques autres bricoles que j’aimerais bien tester (architecture, perspective, stylisation), mais il faudra que je trouve un moyen d’ouvrir un autre compte gratuit. Je n’ai pas envie de payer Midjourney d’une part à cause de leur éthique d’entraînement discutable, mais aussi parce qu’il y a des alternatives gratuites super puissantes. Maintenant attaquons Dall-E !5 points

-

La grosse conclusion Bien bien ! Nous voilà donc au bout de ce gros banc de test. Globalement, on a vu que les IA ne savent pas tout faire et chacune ont leurs points faibles et leurs points forts. Si vous voulez faire des memes, préférez Crayon. Si vous voulez juste des jolies choses sans grand contrôle, préférez Midjourney, mais oubliez les mélanges improbables trop innovants. Ne mettez pas d’argent dans Dall-E. Il y a bien mieux gratuitement. x) Si vous voulez une liberté absolue ou un style très spécifique, et que vous avez un bon ordi et pas peur de bidouiller un peu la technique, préférez Stable Diffusion. Je le trouve intéressant pour faire du brainstorming aussi. Concernant la progression des IA, on se rend compte que plus la finition des images est pointue, plus l’IA a du mal à respecter le prompt. C’est la preuve que ces modèles généralistes butent déjà sur une limite et tombent dans le surentraînement. De plus, plus on cherche quelque chose de précis et complet, plus c’est difficile d’obtenir ce qu’on veut. De nombreuses informations du prompt sont passées sous silence. Changer d’approche pour améliorer les IA s’annonce donc indispensable. Les géants de la tech l’ont déjà compris puisque Microsoft et Google ont expérimenté et proposent déjà des outils de customisation de modèles existants. La spécialisation, en fait, on y vient déjà et la suite logique est le développement d’outils permettant de créer facilement des modèles spécifiques pour chaque projet. Mon choix perso Bon, dans tout ça, où va ma préférence ? Et bien ça vous paraîtra sûrement évident, mais c’est Stable Diffusion que je préfère. x) Au-delà d’un simple produit, il s’agit de tout un écosystème open source exploitable gratuitement et à l’infini. On peut le faire tourner chez soi sans être gêné par les files d’attente ou les surcharges de serveur. Il propose une plus grande liberté créative dans la mesure où on peut le customiser, le spécialiser selon ses propres besoins, avec son propre style ou en faisant des mélanges improbables, comme ça nous chante. Et pour peu qu’on sache un peu coder en Python, on peut lui faire générer des données en masse de façon automatisée ou encore créer sa propre interface graphique avec des fonctions spécifiques à ses besoins perso. Bref ! On peut en faire vraiment ce qu’on veut sans dépenser un rond (à part la facture d’électricité). Pistes d’utilisation pour les artistes D’un côté, j’espère que les procédures aboutiront pour empêcher les entreprises de l’IA de faire n’importe quoi et de s’en mettre plein les fouilles en pillant le travail des autres. De l’autre, il ne faut pas espérer que l’usage de cette technologie soit arrêté et ceci non pas pour des raisons supposées pro-technologie de ma part mais pour une raison bêtement factuelle et pragmatique : si vous vous êtes baladés dans la liste de modèles de Hugging Face vous aurez sûrement vu les compteurs de téléchargement des modèles les plus populaires. Ils ont été téléchargés des millions de fois. On peut poursuivre en justice quelques entreprises, mais pas des millions de pécores dans leurs pantoufles. Ce serait sans fin. Donc, autant explorer les possibilités d’utilisation pour garder une longueur d’avance sur les nouveaux artistes autoproclamés et les clients pingres qui voudraient se passer de nos services. Voici quelques idées : La fonction texte vers image : -Le brainstorming : Avec des IA qui respectent assez bien le prompt, il y a moyen de tester des trucs improbables et d’en tirer des idées d’esthétiques ou de design. -Tranches de fou rire : Avec les copains, on a trouvé un petit côté pochette surprise addictif et rigolo. On en pleure de rire. x) Image vers image : -Filtre de finition ou de stylisation : Avec cette méthode il est possible d’accélérer les étapes fastidieuses de finition tout en gardant le contrôle de la composition, de la lumière et du style. (J’ai fait un test que je vous présenterai.) -Création d’assets : Avec le test de mon petit arbre, je me dit qu’il y a moyen de créer des petits éléments utilisables de la même manière qu’une photo dans un projet de photobashing ou à base de texturing photo ou encore dans un projet en 3D. La technique est identique. La source de l’image est juste différente. (Pas encore testé, mais c’est prévu) -Plaquer le design d’un personnage sur une pose prise en photo : Ça, c’est encore très technique. Faut mettre les mains dans le camboui. En tout cas, il commence à y avoir des prototypes dans ce sens. (Pas encore testé, mais c’est prévu) Tout ça, c’est pour créer des images, mais je vois aussi d’autres possibilités d’applications à expérimenter. J’ai un projet de jeu avec génération procédurale d’environnements dans les cartons. Je pense qu’il y a moyen d’intégrer ce genre de technologie pour enrichir les décors en générant des assets 2D à la volée. Il faudra mettre en place des astuces pour accélérer la génération d’images qui est pour le moment trop lente pour ça, mais j’ai déjà des pistes en tête. Je suis aussi en train de lire le chapitre sur l’apprentissage renforcé dans un de mes gros manuels de deep learning. C’est le type d'algorithme qui a été utilisé pour entraîner des IA pour jouer au Go ou à d’autres jeux. Je pense que cette technologie peut permettre d’aller plus loin que de simplement fournir des adversaires virtuels plus performants. Ça pourrait être un moyen d’entraîner des PNJ dans un RPG (par exemple) et ainsi proposer des interactions plus riches aux joueurs. Je pense qu’il y a moyen d’apporter de nouvelles expériences de jeu. Je ne sais pas ce que chacun d’entre vous projette de faire dans le milieu de l’art, mais en ce qui me concerne, je fais partie de ces petits artistes qui ont des projets perso sur les rails mais qui n’ont pas les moyens de recruter des cohortes d’artistes pour faire sous-traiter le boulot, ni assez de temps libre pour pouvoir tout faire soi-même à la seule force du poignet (parce que boulot alimentaire pour bouffer) d’autant que ma réserve d’énergie est modeste du fait de mon handicape neurologique. Donc à titre personnel, je vois au travers de ces nouvelles technologies une chance de voir aboutir tous ces projets dont je ne peux malheureusement pas vivre (des BD, des jeux…). Ça faisait déjà plusieurs années que je faisais des recherches et des développements pour résoudre ce problème de temps, mais ce n’était jamais suffisant. Il est évidemment hors de question d’en faire une béquille, mais bien de les maîtriser pour aller plus loin plus vite. Les multinationales qui se reposent sur leurs lauriers y verront peut-être un moyen de faire des économies… Dans un premier temps. Mais je pense qu’il ne faut pas sous-estimer l’orgueil et l’ambition de certains et que des startups voulant être kalif à la place du kalif en profiteront pour lancer des projets plus ambitieux. Certains analystes estiment d’ailleurs que la technologie de l’IA va apporter une nouvelle vague de milliardaires. Et qui dit moins de moyens nécessaires à ambition égale dit aussi possibilité de court-circuiter producteurs et autres éditeurs et donc de prendre plus de risques d’innover puisqu’il n’y aura pas un comptable au-dessus pour dire “Houlala ! Trop original ton idée. Contente toi de faire un truc standard. Faut rentabiliser”. Donc je pense au final qu’il va y avoir des opportunités à prendre et qu’il faut rester ouvert pour pouvoir les saisir. Voilà, voilà ! J’ai encore 2 autres articles sous le coude à vous partager. Le premier pour vous montrer comment faire tourner des IA en local sur votre PC gratuitement, le second pour vous montrer un workflow avec une phase d’IA mais qui change de l’habituel “générer une image par’IA avec un prompt et retoucher ensuite” et qui vous redonne le contrôle de votre création. Demain je poste celui sur l'installation de Stable Diffusion en local. Bonne soirée tout le monde !4 points

-

Les variantes de Stable Diffusion Le modèle original de Stable Diffusion n’est pas forcément bon dans tous les domaines, mais son point fort, c’est son statut open source. Ceci permet à des petites équipes, voire des particuliers de créer des versions customisées éventuellement spécialisées, permettant ainsi de compenser les points faibles du modèle original et même de l’étendre. Il est possible de créer son propre modèle depuis zéro avec ses propres données, soit d’affiner/spécialiser un modèle existant avec quelques images supplémentaires (ça peut aller de 4 ou 5 à plusieurs dizaines de milliers). Ceci permet de créer un modèle avec son propre style de dessin par exemple. Quand je vous disais qu’il existait déjà plusieurs milliers de variantes tout-à-l’heure, je déconnais pas. Vous pouvez les explorer sur Hugging Face dans la catégorie des modèles texte vers image sur cette page : https://huggingface.co/models?pipeline_tag=text-to-image&sort=downloads Il y en a plus de 2500 à l’heure où j’écris ces lignes. Vous pouvez trouver tout type de délires : des versions enrichies de Stable Diffusion, des versions spécialisées dans un style spécifique, des versions spécialisées sur un sujet en particulier. Voici quelques exemples pour vous donner une idée de ce qu’on peut trouver : Anything-v4.0 : https://huggingface.co/andite/anything-v4.0 Spécialisé dans les animes. Il sert de base à beaucoup d’autres modèles spécialisés animes. Portrait+ : https://huggingface.co/wavymulder/portraitplus Spécialisé dans les portraits de divers styles. Mitsua Diffusion One : https://huggingface.co/Mitsua/mitsua-diffusion-one Une tentative de modèle basé uniquement sur des données publiques ou dont la permission a été obtenue. Ghibli Diffusion : https://huggingface.co/nitrosocke/Ghibli-Diffusion Un modèle spécialisé dans le style Ghibli. Steampunk-Diffusion : https://huggingface.co/AIArtsChannel/steampunk-diffusion Un modèle spécialisé dans les designs steampunk. Paper Cut Model : https://huggingface.co/Fictiverse/Stable_Diffusion_PaperCut_Model Un modèle qui vous permet de tout transformer en paper cut. Vulcan Diffusion : https://huggingface.co/mitchtech/vulcan-diffusion Un modèle qui permet de transformer n’importe qui en vulcain. El Risitas Model : https://huggingface.co/Fictiverse/ElRisitas Un modèle qui permet de placer El Risitas dans n’importe quelle situation : El Risitas en Hulk, El Risitas en Simpson, El Risitas en Han Solo… Quand je vous dis qu’on peut vraiment faire n’importe quoi en customisant Stable Diffusion. 8D Je suis étonnée de ne pas encore avoir trouvé de modèle spécialisé dans les couvertures de Martine. Je n’ai pas encore testé la création de variantes de Stable Diffusion, mais j’ai fait un gros, très très gros test automatisé de plusieurs modèles différents qui m’intéressaient. Vous pouvez voir les résultats complets sur cette page : https://suiseipark.com/Demos/AI/TestBench/index.html /!\ N’ouvrez pas cette page sur mobile ! Il y a plus de 2000 images et pas de dispositif de chargement progressif. C’est une bête page HTML. Ne scrollez pas trop vite non plus. Votre navigateur pourrait ne pas apprécier. /!\ Vous pouvez agrandir les images en cliquant dessus et naviguer avec les flèches ou les touches fléchées du clavier. Avant de cliquer, petit aperçu de ce à quoi ça ressemble. Ce banc de test se compose de plusieurs tableaux. Le premier est une série de tests en mode texte vers image. Il sert à faire un état des lieux des points forts et des points faibles de chaque modèle. Les suivants sont tous des tests en mode image vers image. Chaque tableau correspond à une même image d’entrée. Chaque ligne correspond à un modèle (dont le lien est cliquable) et chaque colonne correspond à un niveau de filtrage par l’IA. Plus la valeur est proche de 0 plus le résultat ressemblera à l’image originale, plus la valeur sera proche de 1, plus l’IA sera libre d’improviser et plus le résultat ressemblera aux images d’entraînement. J’ai fait des tests assez variés allant des formes géométriques simples à des objets figuratifs. Mon exemple préféré, c’est le test de l’arbre. L’idée derrière est de voir comment chaque modèle peut apporter de la texture ou de la stylisation en fonction de l’image d’entrée afin de m’en servir comme d’un filtre ou encore pour générer des données d’entraînement pour des mini IA de ma confection encore plus spécialisées, plus maîtrisées et plus rapides. Vous noterez que j’ai testé un modèle de pixelart dans le lot… Bon, ce style en IA, c’est pas pour tout de suite. x) Ce banc de test se verra complété de quelques tableaux supplémentaires au fil des prochaines semaines. Autres produits/services J’ai simplement testé les IA de génération d’images les plus connues, mais en fait il y en a plein d’autres. C’est une vraie mode. Ça pope dans tous les sens en ce moment. Et ils disent tous sur leurs sites qu’ils sont les meilleurs alors qu’ils proposent les mêmes choses ! x) Beaucoup sont basés sur Stable Diffusion d’ailleurs, beaucoup d’autres ne précisent pas s’ils utilisent Stable Diffusion ou leur propre algorithme. https://lexica.art/ (Stable Diffusion) https://starryai.com/stable-diffusion (Stable Diffusion) https://images.ai/ (Stable Diffusion) https://stablecog.com/ (Stable Diffusion) https://aiseo.ai/products/ai-art-generator.html (Stable Diffusion) https://stablediffusionweb.com/ https://photosonic.writesonic.com/?via=leptidigital https://www.jasper.ai/art https://deepdreamgenerator.com/about https://www.zmo.ai/ai-art-generator/ https://deepai.org/machine-learning-model/text2img https://www.creativefabrica.com/spark/ai-image-generator/ https://runwayml.com/ai-magic-tools/text-to-image/ https://hotpot.ai/art-generator?s=footer-gallery https://www.aiimagegenerator.org/ Petites statistiques sur les tests J'ai fait quelques statistiques pour résumer les tendances observées dans les tests que nous venons de faire. Pour chaque thème j'évalue le respect du prompt ainsi que le niveau de finition. Les IA sont à chaque fois listées de la plus performante à la moins performante sur le test et sur le critère. Quand plusieurs IA se trouvent dans les mêmes crochets, c'est qu'elles donnent un résultat de niveau similaire. classical oil paint of a jungle and water fall above a small lake, midday, by vernet Respect du prompt : [Dall-E et Craiyon], [Midjourney et Stable Diffusion] Finition : [Stable Diffusion], [Midjourney et Dall-E], [Craiyon] classical oil paint of a very detailed realistic medieval castle, by vernet Respect du prompt : [Dall-E et Craiyon], [Stable Diffusion et Midjourney] Finition : [Midjourney], [Stable Diffusion], [Dall-E et Craiyon] classical oil paint of a very detailed realistic snowy mountain, by vernet Respect du prompt : [Stable Diffusion, Dall-E et Craiyon], [Midjourney] Finition : [Midjourney], [Stable Diffusion], [Dall-E], [Craiyon] classical oil paint a of cloudy sky, by vernet Respect du prompt : [Dall-E], [Craiyon], [Midjourney], [Stable Diffusion] Finition : [Midjourney], [Stable Diffusion et Dall-E], [Craiyon] classical oil paint of a very detailed futuristic starship, by vernet Respect du prompt : [Dall-E], [Stable Diffusion], [Midjourney et Craiyon] (Note : Midjourney perd le rendu peinture, Craiyon n'arrive pas à designer quelque chose qui ressemble à un vaisseau) Finition : [Midjourney], [Stable Diffusion], [Dall-E], [Craiyon] classical oil paint of a a very detailed futuristic warrior with golden armor, by vernet Respect du prompt : [Midjourney, Stable Diffusion, Craiyon et Dall-E] (Note : Midjourney perd le rendu peinture, les autres perdent l'aspect futuriste. Il y a définitivement des mélanges qu'on ne peut pas faire.) Finition : [Midjourney], [Stable Diffusion et Dall-E], [Craiyon] classical oil paint of a homosexual couple hugging each other, by vernet Respect du prompt : [Midjourney, Dall-E], [Stable Diffusion], [Craiyon] Finition : [Midjourney], [Dall-E et Stable Diffusion], [Craiyon] blue dragon with orange spots Respect du prompt : [Midjourney], [Craiyon], [Dall-E et Stable Diffusion] Finition : [Midjourney], [Craiyon], [Dall-E et Stable Diffusion] goku making kamehameha Respect du prompt : [Midjourney, Craiyon, Stable Diffusion et Dall-E] (Note : Midjourney est celui qui se rapproche le plus de la pose du Kaméhaméha, mais les autres s'adaptent mieux aux demandes sur le style) Finition : [Midjourney], [Stable Diffusion], [Craiyon], [Dall-E] (Note : Midjourney fait de plus jolies couleurs que Stable Diffusion, mais ce dernier colle plus au style officiel. Niveau anatomie, c'est pété pareil.) vladimir putin drawn by akira toriyama Respect du prompt : [Stable Diffusion], [Craiyon], [Midjourney], [Dall-E] (Note : Censure de Dall-E) Finition : [Midjourney], [Craiyon], [Stable Diffusion] (Note : Dall-E on ne peut pas savoir puisqu'il ne veut pas le faire.) Goku fighting Putin on a ring Respect du prompt : [Craiyon], [Midjourney], [Stable Diffusion] (Note : Censure de Dall-E) Finition : [Stable Diffusion], [Midjourney], [Craiyon] (Note : Dall-E on ne peut pas savoir puisqu'il ne veut pas le faire.) Lewis Hamilton and Max Verstappen hugging each other Respect du prompt : [Craiyon], [Dall-E, Stable Diffusion], [Midjourney] Finition : [Midjourney], [Dall-E, Stable Diffusion], [Craiyon] Nombre total de thèmes : 12 Inversion respect du prompt/finition : 8 Correspondance respect du prompt/finition : 2 Sans tendance notable : 2 On peut noter une tendance générale : plus une IA donne de belles finitions, plus elle a de difficultés à respecter les informations du prompt. C’est comme l’incertitude d’Heisenberg en mécanique quantique : on ne peut pas avoir les 2 à la fois. On atteint donc une limite. Si les développeurs veulent la dépasser sérieusement, il faudra changer d’approche. Au risque de jouer les disques rayés, la spécialisation des IA et le travail en collaboration avec les artistes plutôt que dans leur dos pour créer des données d’entraînement maîtrisées me paraissent indispensables pour faire de vrais progrès. Voilà ! Il est temps de passer à la conclusion de tout ça ! 😄4 points

-

L’écosystème Stable Diffusion Alors Stable Diffusion, c’est compliqué, c’est la jungle ! x) Cette IA, développée par le groupe CompVis (Computer vision) de l’université Louis-et-Maximilien de Munich et entraînée avec la collaboration de Stability AI et Runway, a pour particularité d’être open source. Son code source et le modèle sont donc distribués gratuitement. Bien que l’interface en ligne de Stability AI soit payante (avec un essai gratuit), on peut se débrouiller pour s’en servir entièrement gratuitement, soit en ligne, soit en local sur son ordi perso (pour peu qu’il soit assez puissant). L’installation en local fera l’objet de l’article suivant. La conséquence de ce statut open source c’est qu’il existe déjà plusieurs milliers de variantes du modèle. Je n’exagère pas. Plusieurs milliers ! x) Vous verrez ça quand on abordera le cas de la plateforme Hugging Face. https://huggingface.co/ Parmi les fonctionnalités disponibles : -Texte vers image -Prompt négatif (dépend des interfaces) -Image vers image (dépend des interfaces) -Définir les dimensions de l’image (dépend des interfaces) -Agrandissement des images générées (dépend des interfaces) -Inpainting (dépend des interfaces) -Outpainting (dépend des interfaces) Les interfaces en ligne En terme d’interface graphique, on a l’embarras du choix. On va faire une petite liste d’interfaces en ligne non exhaustive et en choisir une. En premier lieu il y a l’interface web officielle de Stability AI, Dream Studio : https://beta.dreamstudio.ai/ Elle est payante avec un système de crédits. Une centaine de crédits gratuits sont offerts d’office, ce qui permet de générer environ 500 images. Au-delà, on peut acheter des crédits supplémentaires. Stability AI propose aussi un plugin pour Blender ( https://platform.stability.ai/docs/integrations/blender ) et pour Photoshop ( https://platform.stability.ai/docs/integrations/photoshop ). Ces plugins font appel aux serveurs de Stability AI, donc il vous faut un compte sur leur site. Ces plugins sont donc soumis au même système de crédits que Dream Studio. Night Café ( https://nightcafe.studio/ ) est une interface graphique qui permet d’utiliser plusieurs modèles dont Stable Diffusion et Dall-E. Il y a une limitation : cette interface ne propose que la fonction texte vers image. Le cas Hugging Face ( https://huggingface.co/ ). Hugging Face est une plateforme d’hébergement et de partage de modèles de deep learning de tout type. L’interface de la plateforme est très proche de github. Elle permet aussi d’héberger des interfaces web qui permettent d’utiliser les modèles directement en ligne. Par contre, gare à l’affluence. Il y a des files d’attente. N’importe qui peut développer son interface pour utiliser le modèle de son choix sur la plateforme, donc, c’est le boxon, il y en a plein partout. x) Ces interfaces sont entièrement gratuites, mais leur usage et en trouver une bonne est un peu délicat. Tests avec Night Café On va d’abord commencer par le traditionnel test du modèle original. Pour les tests texte vers image, on va utiliser Night Café. On n’a pas besoin de s’inscrire et on peut l’utiliser entièrement gratuitement. Night Café utilise la version 1.5 de Stable Diffusion. Prompt : classical oil paint of a jungle and water fall above a small lake, midday, by vernet Prompt : classical oil paint of a very detailed realistic snowy mountain, by vernet Sur les décors naturels, les résultats sont comparables à Midjourney. Prompt : classical oil paint of a very detailed realistic medieval castle, by vernet Sur l’architecture c’est un peu plus laborieux, mais j’avais aussi fait une grosse quantité de tests avec un château pour une expérimentation et sur la quantité on peut avoir des choses assez abouties. Prompt : classical oil paint a of cloudy sky, by vernet Prompt : classical oil paint of a very detailed futuristic starship, by vernet Pour le vaisseau spatial il a essayé des choses intéressantes (notamment la dernière image) tout en conservant le style. Il doit y avoir moyen de tirer des idées de design intéressantes sur la quantité. En tout cas, ce qui est proposé durant mes tests est plus original que Midjourney. Prompt : classical oil paint of a a very detailed futuristic warrior with golden armor, by vernet Bon, là, on repassera pour le cadrage, mais ça doit pouvoir se résoudre en demandant des dimensions différentes (l’option est disponible sur Night Café). Pour le côté futuriste, bof bof, mais il essaye quand même, donc peut-être que sur la quantité on peut trouver des choses intéressantes. Entre ça et les vaisseaux y’a moyen d’imaginer un genre de rétro-futurisme typé 17/18ème siècle. Je pense avoir trouvé un outil à brainstorming. Le style demandé est en tout cas respecté. Prompt : classical oil paint of a homosexual couple hugging each other, by vernet Là, respect de la consigne un coup sur 2 et cadre systématique. On reviendra pas sur les interactions entre personnages. Ça pose problème à toutes les IA et c’est logique. x) Passons au dragon. Prompt : blue dragon with orange spots Comme pour Craiyon, sans information supplémentaire, c’est assez paumé. Prompt : professional illustration of a blue dragon with orange spots, cartoon style Prompt : professional illustration of a blue dragon with orange spots, comics style Avec des demandes de stylisation aussi c’est paumé. Prompt : photorealistic very detailed blue dragon with orange spots Il s’en sort un peu pieux quand on lui demande quelque chose de “photoréaliste”. Prompt : a photo of a majestic dragon De nouveau des statues de temple. Prompt : a photo of a majestic fantasy dragon Et là on sait que des visuels de cartes Magic ont été pris dans la base d’entraînement. x) Moralité : les dragons, c’est pas tellement le truc de la version de base de Stable Diffusion. Passons aux tests plus difficiles avec le Kaméhaméha de Goku. Prompt : goku making kamehameha Prompt : goku in the kamehameha pose Prompt : goku joining his hands to make a kamehameha J’ai essayé plusieurs variantes du prompt et pas moyen d’avoir la pose du Kaméhaméha. Par contre, le personnage est reconnaissable et le rendu, bien que pété, est assez fidèle au style officiel. Les poses sont globalement assez lisibles. Passons aux bêtises avec Poutine. Prompt : vladimir putin drawn by akira toriyama Prompt : vladimir putin in toriyama style Il faut faire beaucoup d’essais mais il a tout de même tenté quelques bricoles. Il doit y avoir moyen de tomber sur quelques heureux accidents en persévérant. Prompt : Goku fighting Putin on a ring Pas moyen d’avoir Poutine dans l’affaire, mais la patte DBZ officielle est bien là. Et enfin, le dernier crash test ! Prompt : Lewis Hamilton and Max Verstappen hugging each other Cette fois on est dans des résultats comparables à Dall-E : pilotes sans casques du premier coup, même niveau de finition, pilotes pas toujours reconnaissables. Sur ce test là c’est vraiment Crayon qui donne les résultats les plus rigolos. Tests avec DreamStudio Pour le test image vers image, on va utiliser DreamStudio qui propose la fonctionnalité. On va faire ça avec mon traditionnel arbre lowpoly. Stable Diffusion propose la possibilité d’associer un prompt à l’image d’entrée pour guider l’IA. L’option Image Strength en haut permet de dire à quel point le résultat doit être fidèle à l’image d’entrée. Et voici le résultat du test. Cette fonction avec les IA est tout simplement ma préférée : elle permet de contrôler la composition de son image, la palette ainsi que la lumière. Il y a moyen de s’en servir comme filtre de finition ou de stylisation ou encore de créer des petits assets utilisables dans un projet à base de photobashing. Cette fonction fait l’objet de la majorité des tests que je vais vous montrer maintenant.4 points

-

3 points

-

3 points

-

3 points

-

3 points

-

3 points

-

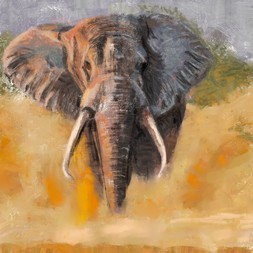

Merci @Yun77 d'avoir pris le temps de répondre de manière si complète et détaillée à mes questionnements. J'apprécie beaucoup.☺️ Pour ce qui est du blending ce n'est pas réellement mon focus tout en l'étant. C'est à dire que si on veut rendre quelque chose d'à peut près propre il faut en passer par là. Cela dit il existe d'autre techniques, que je ne maîtrise pas du tout, où les coups de brush restent apparent mais on sent que c'est voulu. D'ailleurs souvent cela donne des illustrations bien plus dynamiques. Je recopie des trucs depuis des années (photos et autres...) Si j'y passe des heures cela peut être très ressemblant mais ça manque de vie. Y'a rien qui passe. Par exemple, le portrait de @Chaz hier n'était pas une pure reproduction de la photo, mais une interprétation plein de douceur. ça racontait quelque chose, ça faisait passer un sentiment. Et ça c'est chouette. C'est à ça le but, raconter quelque chose, faire ressentir quelque chose pas juste c'est beau ou on dirait une photo... J'arrive pas à sortir du recopiage, d'abord pour des problèmes technique mais pas que....ou peut être que cela joue grandement, je ne sais pas trop en fait. Mon but en ce moment c'est d'acquérir de la rapidité pour pouvoir travailler plus de choses différentes dans la journée et progresser plus vite. Je pense aussi qu'il faut que je m'amuse plus, que j'expérimente des brushs, des outils et des techniques différentes. Je me suis limité à 3/4 brushs depuis longtemps maintenant pour ne pas m'éparpiller, pour acquérir de la technicité en dessin pur et rending. Je n'ai jamais essayé la technique du doigt ou du brush mélangeur, par manque de temps. Le temps, le temps...c'est un dictateur chez moi...ainsi que le doute sur mes capacité à travailler efficacement. Mais bon, j'ai sans doute progressé depuis le mois de janvier, bien qu'il ne soit pas toujours facile de s'en rendre compte. Ne t'inquiète pas je ne prends pas du tout de travers tes remarques sur les erreurs de proportions bien au contraire. Que je travail en croquis ou en masse, elles sont bien présentes. Quand aux cheveux c'est une de mes bêtes noires. Je ne sais pas faire de belles courbes. Les mèches c'est à travailler! T'es retour sont super intéressants et motivants. Savoir commenter le travail des autres est très important pour progresser soi-même et vraiment agréable à recevoir. Je te remercie encore pour ton message. Bon, j'arrête là, je suis moi aussi en train d'écrire un roman. 😄 Voici le portrait du jour. Il m'a pris 2h. J'ai commencé déjà par étudier réellement la photo, les teintes qui l'a composent, plutôt que de partir au jugé et de devoir repasser 10 fois au même endroit, pour arriver un une couleur + ou - approchante. Je ne me suis pas trop attardé sur le blending cette fois-ci. J'ai l'impression qu'il est du coup plus dynamique que celui d'hier.3 points

-

3 points

-

Craiyon (Dall-E Mini) L’ancien nom prête à confusion (et c’est pour ça qu’il a été changé) mais Dall-E Mini n’a en vérité pas de rapport avec Dall-E. Derrière ce projet il y a une petite équipe qui semble faire ça sur temps libre. Quand la première version de Dall-E est sortie, ils ont trouvé ça trop chouette et ils se sont dit qu’il était important qu’une variante open source existe pour que cette technologie ne soit pas le monopole des géants de la tech. https://www.craiyon.com/ Ce service est totalement gratuit, mais on peut payer un abonnement pour obtenir des temps de calcul plus rapides et aider au financement des serveurs. La V2 a été mise en ligne courant février 2023. La version précédente est toujours disponible dans un coin de web : https://huggingface.co/spaces/dalle-mini/dalle-mini Fonctionnalités disponibles : -Texte vers image Et c’est repartie pour une série de tests. Commençons par les tentatives de peinture. Prompt : classical oil paint of a jungle and water fall above a small lake, midday, by claude joseph vernet Prompt : classical oil paint of a very detailed realistic medieval castle, by claude joseph vernet Prompt : classical oil paint of a very detailed realistic snowy mountain, by claude joseph vernet Prompt : classical oil paint a of cloudy sky, by claude joseph vernet Prompt : classical oil paint of a very detailed futuristic starship, by claude joseph vernet Prompt : classical oil paint of a a very detailed futuristic warrior with golden armor, by claude joseph vernet Prompt : classical oil paint of a homosexual couple hugging each other, by claude joseph vernet Alors, vu de loin, le rendu peinture fonctionne plutôt bien. On commence déjà à voir quelques difficultés avec l’architecture et les personnages. Pour le vaisseau spatial, par contre, il est assez perdu. Il faut pas trop regarder de près parce que clairement, la finition, ce n’est pas son point fort comparé aux autres IA. Passons ensuite au dragon à pois. Prompt : blue dragon with orange spots Pour ce premier jet, c’est très très abstrait. Faisons d’autres essais avec des informations de style supplémentaires. Prompt : professional illustration of a blue dragon with orange spots, cartoon style Pour le style cartoon, même si la finition n’est pas du niveau de Midjourney, c’est le plus réussi en matière de respect du prompt. Prompt : professional illustration of a blue dragon with orange spots, comics style Prompt : professional illustration of a blue dragon with orange spots drawn by michael turner Pour ce qui est du style comics, là ça coince. Prompt : photorealistic very detailed blue dragon with orange spots Prompt : a photo of a majestic dragon Crayon s’en sort bien sur les rendus photoréalistes, mais l’aspect fantasy se perd au profit du domaine animalier ou des statues de temple. Prompt : a photo of a majestic fantasy dragon Ça devient plus compliqué lorsqu’on demande quelque chose qui relève de l’imaginaire. Passons aux épreuves plus compliquées. Prompt : goku making kamehameha Prompt : goku making kamehameha drawn by toriyama Prompt : goku making kamehameha in TOEI style L’anatomie est évidemment toute pétée, mais il y a des tentatives d’approcher la pose du Kaméhaméha. Les personnages sont à peu près reconnaissables ainsi que le style aussi. Ensuite, les âneries avec Poutine. Prompt : vladimir putin drawn by akira toriyama Il essaye bien de dessiner Poutine, mais pour le style Toriyama, on repassera. Prompt : Goku fighting Putin on a ring Pour le combat Goku vs Poutine, il y a quelques images où il a bien essayé de respecter le prompt. Et enfin, le crash test final : le câlin entre Hamilton et Verstappen ! Prompt : Lewis Hamilton and Max Verstappen hugging each other Et bien en fait, bien que la finition soit en dessous des autres, niveau respect du prompt c’est vraiment l’IA qui réussit le mieux ! Les pilotes sont reconnaissables et les combinaisons aussi. Mention spéciale pour la dernière qui a carrément inverser les combinaisons associant Hamilton à RedBull et Verstappen à Mercedes. Je crois que je tiens un meme en or ! x’D Maintenant attaquons la falaise Stable Diffusion !3 points

-

Dall-E 2 Dall-E 2 est le dernier modèle en date de création d’image d’OpenAI, la boîte qui est aussi à l’origine de ChatGPT qui a volé la vedette dans les médias. https://openai.com/product/dall-e-2 Il s’agit d’un service en ligne payant avec un système de crédits. Vous bénéficiez de 50 crédits gratuits à l’inscription, puis 15 crédits gratuits par mois. Pour obtenir davantage de crédits, il faudra mettre la main au porte monnaie. Fonctionnalités disponibles : -Texte vers image -Variations d’une image -Inpainting -Outpainting -Historique Comme pour Midjourney, on va commencer par les standards Prompt : classical oil paint of a jungle and water fall above a small lake, midday, by vernet Le rendu ressemble plus à de l’impressionnisme qu’à de la peinture classique. A tout hasard, j’ai donc précisé le prénom de l’artiste, la famille Vernet ayant connu un grand nombre de générations de peintres. Prompt : classical oil paint of a jungle and water fall above a small lake, midday, by claude joseph vernet Ça correspond mieux à l’époque visée. Prompt : classical oil paint of a very detailed realistic medieval castle, by claude joseph vernet Prompt : classical oil paint of a very detailed realistic snowy mountain, by claude joseph vernet Prompt : classical oil paint a of cloudy sky, by claude joseph vernet Prompt : classical oil paint of a very detailed futuristic starship, by claude joseph vernet C’est pas jojo, mais au moins il essaye bien de générer des vaisseaux tout en gardant le rendu peinture. Prompt : classical oil paint of a a very detailed futuristic warrior with golden armor, by claude joseph vernet Ce coup-ci, on peut oublier l’aspect futuriste. Prompt : classical oil paint of a homosexual couple hugging each other, by claude joseph vernet Les interactions entre personnages sont toujours un problème. Maintenant on va reprendre le dragon à pois oranges. Prompt : blue dragon with orange spots Prompt : professional illustration of a blue dragon with orange spots, cartoon style Prompt : professional illustration of a blue dragon with orange spots, comics style Prompt : professional illustration of a blue dragon with orange spots drawn by michael turner Les résultats sont pas sexy, mais c’est un peu plus souple en matière de style que Midjourney. Globalement Dall-E semble plutôt orienté vers le photoréalisme, j’ai donc fait des essais en ce sens. Prompt : photorealistic very detailed blue dragon with orange spots Prompt : a photo of a majestic dragon Prompt : a photo of a majestic fantasy dragon La finition est très en dessous de Midjourney, par contre, je vois moins d’absurdités anatomiques. Maintenant on attaque les trucs les plus compliqués. Mon habituel Goku qui fait un Kaméhaméha. Prompt : goku making kamehameha Prompt : goku making kamehameha drawn by toriyama Prompt : goku making kamehameha in TOEI style Là on a vraiment l’impression que Dall-E a été entraîné avec des dessins d’enfants. Ensuite, les petites mises en scène avec Poutine… Prompt : vladimir putin drawn by akira toriyama Prompt : Goku fighting Putin on a ring Bon, là ça va pas bien loin. Censure pure et simple. C’est amusant parce que j’ai lu chez certains défenseurs/utilisateurs des IA qui cherchent à se justifier qu’en art ce qui était important c’était l’idée et l’opinion, pas l’exécution. Sauf que si on censure on peut pas exprimer grand chose comme opinion et quand on voit les showcases, on a surtout l’impression que tout le monde a les mêmes idées et que ça veut surtout pas s’engager sur aucune question sensible. x) C’est joli, mais niveau message à transmettre, c’est juste le vide intersidéral. Certains de mes sujets de test ici sont plus engagés et provoc’ que ce qu’on trouve dans les showcases alors qu’il ne s’agit que d’un fichu banc de test. C’est dire ! ¬¬ Aux artistes IA : Ok, les idées sont importantes… Ben mouillez-vous alors ! … Ou admettez que la possibilité de générer de jolies images sans apprendre à dessiner est un pansement pour votre égo. Pour le coup, les gens qui n’ont pas d’autre prétention que de faire des memes sont plus créatifs et ont plus de cran. Passons au dernier crash test : le câlin entre Hamilton et Verstappen. Prompt : Lewis Hamilton and Max Verstappen hugging each other Cette fois je n’ai pas besoin de tourner la requête en long en large et en travers pour avoir les pilotes sans casque. Ils sont toujours difficiles à reconnaître, mais ça se rapproche de la réalité… Quitte à mettre la tête de Lando Norris à la place de celle de Verstappen. ¬¬ La finition est évidemment moins jolie que Midjourney avec cetains visages passés à l’acide. Dall-E propose aussi de transformer une image d’entrée. Par contre c’est une fonction de variation et on ne peut pas entrer un prompt avec. On ne peut donc pas l’utiliser pour changer le style de l’image d’entrée. Image d’entrée : Les variations sont plutôt réussies, mais c’est pas ce que je cherche. Bon, j’ai quand même obtenu pas mal de résultats bien moches assez loin de ce que l’on peut voir dans les démos, donc j’ai essayé les prompts des démos pour voir si ça au moins ça marchait bien. Prompt : a photo of a happy corgi puppy sitting and facing forward, studio light, longshot Prompt : a photo of a happy corgi puppy sitting seen from the back Prompt : a photo of a happy corgi puppy sitting seen from the side Le corgi, pas de soucis. Ils ont dû mettre beaucoup de photos de corgi dans la base d’entraînement. x) L’autre classique des démos, c’est l’astronaute à cheval. Prompt : An astronaut riding a horse in photorealistic style. L’astronaute à cheval, c’est à la hauteur de ce qui est affiché dans les démos. Globalement, je trouve que ça vaut pas qu’on y dépense de l’argent. On peut avoir mieux pour gratuit. Passons maintenant à Craiyon !3 points

-

Comme je me remets au programme (sur Krita cette fois, et 6 ans plus tard...), je vais reposter mon premier exercice, peint il y a donc 6 ans, même si aujourd'hui j'aurais envie de le modifier, ne serait-ce qu'au niveau du contraste, mais je ne triche pas, je garde celui-là car c'est vraiment ma première illustration en DP, et c'est un thème qui me tient à cœur. Aussi j'ai hâte de le refaire à l'issue du chapitre 10.2 points

-

Bonjour à tous, Je m'appelle Victor.j’ai 23 ans.Je suis sorti depuis peu d'Artfx à Montpellier, où j'étudiais l'animation .Dans les animations je m’occupais des backgrounds. Pendant ces périodes d’études le concept m’a prit aux tripes. Ce qui me passionne dans le concept c’est de donner vie à des illustrations à travers des ambiances, des couleurs et de provoquer des émotions. Je souhaite me réaliser dans le domaine du concept art. De travailler aussi bien dans le jeux vidéo que dans le film d’animation. Pour ce dessin je me suis inspiré de Jouy-aux-arches petit village de Lorraine où je suis né. Je voulais donné une certaine ambiance aux travers des couleurs et des bâtiments déstructurés. Mon univers est plutôt gothique. Mon trait de dessin est pointu, assez rough, j’aime bien le line. C'est mon premier dessin sur Photoshop, j'utilisais Krita principalement. C'est pourquoi j'ai essayé de retrouver des pinceaux similaire sur Krita. Je compte effectuer tous les exercices sur Photoshop étant le logiciel le plus utilisé dans le domaine du concept art. Cette formation m'apportera beaucoup que ça soit au niveau des bases que pour perfectionner mon dessin, je suis très heureux de pouvoir la suivre et de pratiquer. Egalement de m'améliorer dans l'utilisation de Photoshop .Par ailleurs je trouve cela merveilleux qu'il existe une formation dans le concept art. Heureux de pouvoir vous montrer ce premier dessin.2 points

-

2 points

-

Plus mou je sais pas Plus mou je sais pas. Ça lui donne assurément une autre gueule. C'est marrant comme chacune de nos versions raconte un truc différent. Je trouve ton digital très harmonieux. Je vois que tu gère bien les mèches de cheveux. 🙂2 points

-

2 points

-

2 points

-

Hello la compagnie ! Aujourd’hui on va parler workflow avec les IA. Vous avez noté, actuellement la grande mode, c’est de demander à une IA de générer une image à partir d’un texte et de retoucher celle-ci pour en faire quelque chose de correct. En gros, l’IA propose une idée, l’artiste fait la finition. Ça arrange bien les artistes du dimanche qui ne savent pas tenir un crayon, mais ça ennuie les artistes sérieux parce que cette méthode alloue la partie fun de création à l’IA et la partie chiante et laborieuse de finition à l’artiste faisant de lui un ouvrier plus qu’un créateur. Pas sexy, n’est-ce pas ? Bon… Et si on inversait les rôles ? 🙂 J’ai récemment terminé mon tout premier projet incluant l’IA dans le workflow. Il s’agit de l’affiche du prochain festival de BD Vidau’Bulles ( https://www.facebook.com/VidauBulles/ ). Pour résumer le principe du workflow : pour les personnages je suis restée sur des méthodes classiques, pour le décor je suis partie d’une scène que j’ai modélisée en 3D et je me suis faite assister par une IA pour casser le rendu 3D et faire la finition. L’IA joue un rôle comparable à un filtre Photoshop ou à un brush en fait. Les personnages Bon, là, rien de révolutionnaire. Le staff de Vidau’Bulles m’a indiqué que le thème de cette année serait les super héros et qu’ils voulaient mettre à l’honneur les auteurs francophones d’inspiration manga. J’ai donc fait une petite recherche. Je me suis inspirée à la fois de l’armure d’Iron Man (pour le côté super héros) et des armures de tokusatsu (pour le côté japonais). J’ai aussi choisi des couleurs et des motifs qui évoquent le blason de la ville de Vidauban. Le blason de la ville. Ensuite, j’ai crayonné les poses des personnages dans mon carnet ainsi qu’une ébauche de décor. Puis j’ai assemblé le tout dans Affinity Photo et j’ai encré et mis en couleur les personnages dans Procreate. Le décor La 3D Pour mon décor 3D, j’ai commencé par la chapelle Sainte Brigitte (l’un des principaux monuments de la ville). Les IA ne sont pas douées pour la perspective, donc, il vaut mieux soigner un peu la modélisation des éléments architecturaux. Une petite ref’ de la chapelle en question. Pour les éléments naturels, par contre, il vaut mieux ne pas trop pousser. Pour la colline, je me suis contentée de déformer un peu un cylindre. Pour les végétaux, un assemblage de quelques primitives suffit : des cylindres et des sphères pour les arbres, un petit délire à la Minecraft pour les vignes. Pour les maisons lointaines, un cube avec l’ajout d’une arête fait l’affaire. Ensuite, j’ai utilisé les geometry nodes pour créer les villages, les forêts et les champs de vignes. Ensuite, je suis passée à la composition globale. Pour les nuages, j’ai juste repris le modèle du buisson, je l’ai agrandi, mis en blanc et ai appliqué un geometry node pour ajouter quelques sphères aléatoires. Plus qu’à faire un rendu avec Cycle, et voilà ! On en a terminé avec la 3D ! 😄 Bon, par contre, si on met les personnages par dessus cette image, ça jure bien comme il faut. x) On va corriger ça. La finition assistée par IA Pour cette phase là, on ne va pas utiliser la fonction texte vers image, mais la fonction image vers image. On donne une image en entrée de l’IA, un prompt texte pour la guider un peu, on ajuste le niveau de liberté de l’IA puis on lance la transformation. On ne va pas faire ça sur l’entièreté de l’image d’un seul coup. Ça ne fonctionnera pas tout simplement parce que plus une composition est complexe, plus l’IA est paumée. Par ailleurs, selon que l’on filtre des végétaux ou des bâtiments on ne peut pas utiliser le même niveau de liberté pour l’IA. Il n’y a pas de réglage unique adapté à l’image entière. L’astuce consiste donc à diviser l’image du rendu 3D en plusieurs morceaux et de générer des rendus d’IA pour chacun de ces morceaux avec des prompts simples focalisés sur un élément en particulier. J’ai donc découpé mon image comme suit : -1 gros carré pour le ciel -2 carrés pour la colline -1 carré pour la chapelle -1 carré pour le toit de la chapelle -1 carré pour l’escalier devant la chapelle -3 carrés pour les vignes -4 carrés pour les villages -10 carrés pour les forêts Ensuite, j’ai commencé par faire quelques tests avec plusieurs modèles d’IA différents que j’ai sélectionnés sur la base de mon gros banc de test : https://suiseipark.com/Demos/AI/TestBench/index.html Et celui qui a donné les meilleurs résultats, c’est Inkpunk-Diffusion : https://huggingface.co/Envvi/Inkpunk-Diffusion C’est un modèle qui n’a pas du tout été pensé pour le style que je recherchais dans ce projet, mais avec un degré de liberté relativement faible, ça fait le café. Globalement, j’aime bien les rendus de ce modèle. Une fois le modèle choisi, j’ai généré entre 5 et 20 variantes pour chacun de mes carrés. J’ai utilisé l’application DiffusionBee pour cela. Prompt pour le ciel : the sky over the countryside, nvinkpunk Prompt pour la colline : a wooded hill seen from above, nvinkpunk Prompt pour la chapelle : chapel surrounded by forest seen from above, nvinkpunk Prompt pour le toit de la chapelle : Provencal roof seen from above, nvinkpunk Prompt pour l’escalier devant la chapelle : stone staircase seen from above, nvinkpunk Prompt pour les vignes : vineyard surrounded by forest seen from above, nvinkpunk Prompt pour les villages : Provencal village surrounded by forest seen from above, nvinkpunk Prompt pour les forêts : Provencal forest surrounded by villages seen from above, nvinkpunk Ensuite, j’ai sélectionné les variantes qui correspondaient le plus à mes besoins pour chaque carré. Pour certains carrés j’ai utilisé plusieurs variantes que j’ai combinées parce que certaines parties étaient plus réussies sur certaines variantes que sur d’autres. Le souci c’est que ces modèles d’IA génèrent des images assez petites (512x512 pixels) et que je travaille sur un format A3 en 600 dpi. 8D Un algorithme classique d’agrandissement ne sera pas à la hauteur. J’ai donc utilisé une petite IA que j’ai développée spécialement pour agrandir les images (je détaillerai dans un futur article). Elle n’est sûrement pas aussi performante que les services payants proposés en ligne, mais pour mon cas, ça fait largement l’affaire. Bon, maintenant il faut assembler tous les rendus d’IA sélectionnés à la bonne place. Et il me reste plus qu’à faire quelques retouches mineurs pour intégrer l’ensemble proprement. Entre 1 et 2 heures de retouches pour ce projet là. Et voilà notre décor final ! Je suis globalement plutôt contente du résultat, cette approche me paraît plutôt bonne, bien qu’il y ait encore quelques points perfectibles. La chapelle fait encore trop 3D à mon goût. Il va falloir que je fasse des tests et des ajustements supplémentaires pour tout ce qui est architecture. La fonction image vers image a encore un défaut à mon goût : elle ne propose qu’un seul degré de liberté. Si on laisse beaucoup de liberté à l’IA, elle va tout transformer : formes générales, couleurs et textures. J’aimerais bien voir une IA qui permette d’ajuster ces 3 aspects séparément et pouvoir lui dire “Tu changes la texture, mais touche pas aux couleurs et aux formes”. Malheureusement, ce sont des concepts absents de ces modèles. Il y a aussi quelques phases un peu relouds répétitives et pas créatives (enregistrer les carrés du rendu 3D un par un, enregistrer les fichier générés par IA un par un, rassembler les carrés générer par IA) qu’il faudrait que j’automatise avec une petite interface maison afin de gagner du temps et de me focaliser sur les aspects vraiment importants de la réalisation. Je pense que je ferai d’autres images pour affûter la méthode. Ça m’a globalement bien amusée. Voilà, voilà ! J’espère que cette approche qui redonne le contrôle à l’artiste vous aura donné des idées. Bon week-end tout le monde ! 😄2 points

-

L’artiste de demain est-il développeur ? Bon, qu’on se le dise, le grand remplacement des artistes par les IA, je n’y crois pas le début d’une seconde. En revanche, ce dont je suis certaine, c’est qu’elles vont transformer le métier comme l’ont fait l’arrivée du numérique puis de la 3D sur le marché à leur époque. De nouveaux outils vont débarquer et avec eux de nouveaux métiers aussi. Avec Photoshop et la 3D, il y a des métiers qui sont nés et qui n’existaient pas avant. Alors oui, ça implique de faire de la veille sur ce qui existe et sort, de se former, de mettre à jour son panel de compétences. C’est la réalité de n’importe quel métier en fin de compte. Enfin, à condition de changer d’approche. Une collaboration constructive plutôt qu’une guerre destructrice Les boîtes qui développent ces IA de génération d’image à partir de texte se plaisent à faire le buzz en montrant les résultats les plus réussis et les artistes qui s’en servent, même expérimentés, sont plutôt avares en informations quant au nombre de tentatives et aux prompts qu’ils ont utilisés pour obtenir les résultats qu’ils affichent. Mais personne ne parle des 99,9…% de déchets inutilisables parce que la moitié des infos du prompt sont zappées, sans parler de l’anatomie et de la perspective mal assimilées. L’approche est à la fois trop ambitieuse et trop naïve (en plus d’être légalement discutable vis-à-vis du droit d’auteur). Le seul moyen d’avoir assez de données pour cela, c’est d’aspirer les données du web à l’aide de bots. Sauf que ces données, comme expliqué plus tôt, sont chaotiques. Elles comportent des trous et des hashtags non pertinents. Le problème avec le deep learning, c’est que si on n’améliore pas la qualité des données dont on dispose déjà, en ajouter davantage n’améliore pas la qualité de l’IA. On atteint un plafond. L’IA peut même régresser si les nouvelles données injectées sont corrompues avec davantage de trous et de descriptions et hashtags incohérents. Pour dépasser ce plafond et améliorer l’IA, il n’y a pas 36 solutions : il faut retaper la description de chacune des images récoltées sur le web. Vu la quantité, c’est juste IM-POS-SIBLE. x) En fait, il y aurait une possibilité : que les auteurs de chaque image eux-mêmes le fassent… Mais je ne pense pas qu’il soit malin de compter sur eux pour faciliter la tâche de ceux qui pillent leurs créations. Avec la hype, des petits clients type particuliers, petits éditeurs ou artisans vont peut-être être tentés de passer par les IA pour créer leurs images. Ils vont essayer… Mais alors gare à la déception. Reprenons l’exemple du Sangoku qui fait son Kaméhaméha. Imaginez qu’un client potentiel décide de demander ça à une IA plutôt que de commissionner un artiste. Je viens de tester Stable Diffusion. Après une bonne vingtaine de rendus, alors il y a des rendus pas mal où on reconnait un peu Sangoku… Des rendus que je soupçonne d’être obtenus à partir d’une ou deux images seulement aussi (ça renifle le surentraînement). Mais la pose iconique du Kaméhaméha, impossible de l’avoir, ni de près, ni de loin ! Le client, il sera bien obligé de revenir commissionner l’artiste. x) Je pense que les petits clients qui auront été tentés de faire des économies vont vite revenir vers les petits artistes après s’être bien cassés les dents sur des résultats à côté de la plaque où à la qualité discutable. Je vous encourage vraiment à tester ces IA par vous même pour vous en rendre compte, même si vous ne les aimez pas. On craint ce que l’on ne connaît pas, mais on ne craint pas ce que l’on connaît. Si vous avez des idées précises de ce que vous voulez faire ou un brief d’un client à tester, vous verrez que tirer ce que vous voulez de ces IA, c’est… délicat. Pour vraiment passer outre ces défauts, je pense qu’une autre approche va s’imposer. En vérité c’est une approche utilisée depuis bien longtemps parce que le manque de données et de puissance de calcul l’imposait : La spécialisation. Plutôt que d’avoir une grosse IA généraliste qui essaie de créer une image de A à Z pour un résultat approximatif qui nécessitera souvent beaucoup de retouches, combiner plusieurs IA très spécialisées sur les étapes les moins créatives et les plus laborieuses du workflow. Ces IA pourraient donner des résultats beaucoup plus qualitatifs, nécessitant beaucoup moins de retouches, tout en nécessitant peu de données et de puissance de calcul. Piocher ces données sur Internet n’est pas la bonne idée, outre le problème des droits d’auteur, je vais le répéter, sur Internet vous ne maîtrisez pas la qualité des données. Non, le plus simple, c’est de travailler en collaboration avec les artistes. Les recruter pour qu’ils créent les données d’entraînement en échangeant avec eux sur ce qu’on veut que les IA maison sachent faire. Ainsi, la qualité des données sera sous contrôle et normalisée. Ainsi, on peut créer des IA spécifiques aux besoins d’un studio, voire d’un projet. On peut tailler des IA sur mesure qui rendront un style spécifique et unique. Je pense qu’il peut ressortir quelque chose de beaucoup plus positif si les développeurs et les artistes travaillent en collaboration plutôt que les uns contre les autres. Bon, et l’artiste de demain, est-ce qu’il est développeur ? Je pense que de nouveaux profils d’artistes peuvent émerger avec ces nouvelles technologies. Comme pour la 3D avec laquelle un certain nombre d’artistes sont devenus plus techniques à devoir manipuler davantage de chiffres et de math. Les systèmes nodaux de Blender et de Houdini sont d’ailleurs des sortes de langages de programmation. La plupart des logiciels de 3D sont d’ailleurs scriptables avec le langage Python. Un artiste qui a des bases dans ce langage peut donc encore plus tirer partie de ces logiciels. Et bien ça peut être pareil avec les IA. Un artiste qui s’initiera à la data science pourra créer ses propres IA à son image, avec son style, pour réaliser ses propres projets, réaliser des projets plus ambitieux que si cette technologie n’existait pas, ou il pourra mettre en valeur sa compétence double sur le marché du travail. Par contre, un développeur pur jus qui n’a jamais touché un crayon de sa vie ne pourra jamais remplacer l’artiste. Si on reprend la démarche de construction des données de ma petite IA, je doute que quelqu’un qui n’a jamais dessiné de sa vie aura l’idée de prendre en compte les traits de construction, le grain du brush numérique ou de faire des pleins ou des déliés sur ses encrages. Et puis il ne saura tout simplement pas faire de crobards corrects. Oui, le métier va sûrement changer. Les budgets pour des projets d’un même niveau d’ambition vont sûrement baisser et la taille des équipes aussi. Mais qui dit budgets plus modestes dit aussi projets plus accessibles à des petites structures qui ne pouvaient pas les faire avant et aussi possibilité de court-circuiter les producteurs et éditeurs frileux pour faire des projets plus innovants sur le plan créatif. Les indépendants auront plus de possibilités.2 points

-